ПРИМЕЧАНИЕ: данное руководство в настоящее время проходит процесс переписывания после долгого периода без значительных работ. Это работа в процессе, многое отсутствует, а существующее содержимое требует доработки.

Введение

Эта книга является руководством по асинхронному программированию в Rust. Она предназначена для того, чтобы помочь вам сделать первые шаги и узнать больше о продвинутых темах. Мы не предполагаем какого-либо опыта в асинхронном программировании (ни в Rust, ни в другом языке), но мы предполагаем, что вы уже знакомы с Rust. Если вы хотите изучить Rust, вы можете начать с "Языка программирования Rust".

Эта книга состоит из двух основных частей: часть первая — это руководство для начинающих, предназначенное для последовательного чтения, которое проведет вас от полного новичка до среднего уровня. Часть вторая — это набор независимых глав по более сложным темам. Она будет полезна после проработки первой части или если у вас уже есть некоторый опыт с асинхронным Rust.

Вы можете ориентироваться в этой книге несколькими способами:

- Вы можете читать её от начала до конца, по порядку. Это рекомендуемый путь для новичков в асинхронном Rust, по крайней мере для первой части книги.

- Слева на веб-странице находится оглавление.

- Если вам нужна информация по обширной теме, вы можете начать с предметного указателя.

- Если вы хотите найти все обсуждения по конкретной теме, вы можете начать с детального указателя.

- Вы можете проверить, есть ли ответ на ваш вопрос в ЧаВо (Часто задаваемых Вопросах).

Что такое Асинхронное Программирование и зачем оно нужно?

В параллельном программировании программа выполняет несколько действий одновременно (или, по крайней мере, создаёт такое впечатление). Программирование с использованием потоков — это одна из форм параллельного программирования. Код внутри потока написан в последовательном стиле, а операционная система выполняет потоки параллельно. При асинхронном программировании параллелизм полностью осуществляется внутри вашей программы (операционная система не участвует). Асинхронная среда выполнения (которая в Rust является просто ещё одним крейтом) управляет асинхронными задачами совместно с программистом, явно передающим управление с использованием ключевого слова await.

Поскольку операционная система не участвует, переключение контекста в асинхронном мире происходит очень быстро. Более того, асинхронные задачи имеют гораздо меньшие накладные расходы памяти, чем потоки операционной системы. Это делает асинхронное программирование хорошо подходящим для систем, которым необходимо обрабатывать очень много параллельных задач и где эти задачи проводят много времени в ожидании (например, ответов от клиентов или операций ввода-вывода). Это также делает асинхронное программирование хорошим выбором для микроконтроллеров с очень ограниченным объемом памяти и без операционной системы, предоставляющей потоки.

Асинхронное программирование также предоставляет программисту детальный контроль над тем, как задачи выполняются (уровни параллелизма и конкурентности, управление потоком выполнения, планирование и т.д.). Это означает, что асинхронное программирование может быть как выразительным, так и эргономичным для многих применений. В частности, асинхронное программирование в Rust обладает мощной концепцией отмены и поддерживает множество различных вариантов параллелизма (выражаемых с помощью конструкций, включающих spawn и его вариации, join, select, for_each_concurrent и т.д.). Это позволяет создавать компоновываемые и повторно используемые реализации таких концепций, как таймауты, приостановка и регулирование.

Hello, world!

Просто чтобы дать вам представление о том, как выглядит асинхронный Rust, вот пример "hello, world". В нём нет параллелизма, и он не совсем использует преимущества асинхронности. Но он определяет и использует асинхронную функцию и печатает "hello, world!":

// Define an async function. async fn say_hello() { println!("hello, world!"); } #[tokio::main] // Boilerplate which lets us write `async fn main`, we'll explain it later. async fn main() { // Call an async function and await its result. say_hello().await; }

Мы объясним всё подробно позже. Пока обратите внимание, как мы определяем асинхронную функцию с помощью async fn и вызываем её с помощью .await — асинхронная функция в Rust ничего не делает, если её не awaitить1.

Как и все примеры в этой книге, если вы хотите увидеть полный пример (включая Cargo.toml) или запустить его локально, вы можете найти их в репозитории GitHub книги: например, examples/hello-world.

Развитие Асинхронного Rust

Функции асинхронности в Rust разрабатываются уже некоторое время, но это не «завершённая» часть языка. Асинхронный Rust (по крайней мере, части, доступные в стабильном компиляторе и стандартных библиотеках) надежен и производителен. Он используется в production в некоторых из самых требовательных ситуаций в крупнейших технологических компаниях. Однако есть некоторые недостающие части и шероховатости (скорее в смысле эргономики, чем надежности). Вы, вероятно, наткнетесь на некоторые из них во время вашего путешествия по асинхронному Rust. Для большинства недостающих частей существуют обходные пути, и они освещены в этой книге.

В настоящее время большинство пользователей находят шероховатости при работе с асинхронными итераторами (также известными как потоки или streams). Некоторые случаи использования async в трейтах пока плохо поддерживаются. Не существует хорошего решения для асинхронного разрушения (destruction).

Над асинхронным Rust ведется активная работа. Если вы хотите следить за разработкой, вы можете посмотреть на домашнюю страницу Рабочей группы по асинхронности, которая включает их дорожную карту. Или вы можете прочитать цели проекта по асинхронности в рамках Проекта Rust.

Rust — это проект с открытым исходным кодом. Если вы хотите внести свой вклад в разработку асинхронного Rust, начните с документации по внесению вклада в основном репозитории Rust.

-

На самом деле, это плохой пример, потому что

println— это блокирующий ввод-вывод, и обычно это плохая идея — делать блокирующий ввод-вывод в асинхронных функциях. Мы объясним, что такое блокирующий ввод-вывод, в главе TODO и почему вам не следует делать блокирующий ввод-вывод в асинхронной функции, в главе TODO. ↩

Navigation

TODO Intro to navigation

Topic index

Concurrency and parallelism

- Introduction

- Running async tasks in parallel using

spawn - Running futures concurrently using

joinandselect - Mixing sync and async concurrency

Correctness and safety

- Cancellation

Performance

Testing

Index

-

Async/

async -

Futuretrait

-

Multitasking

-

Testing

-

Traits

- async

Future

Часть 1: Руководство по асинхронному программированию в Rust

Эта часть книги представляет собой руководство по асинхронному Rust в стиле учебника. Она предназначена для новичков в асинхронном программировании на Rust. Она будет полезна независимо от того, занимались ли вы асинхронным программированием на других языках или нет. Если да, вы можете пропустить первый раздел или пробежать его глазами для освежения памяти. Вам также, возможно, стоит поскорее прочитать сравнение с async в других языках.

Основные концепции

Мы начнём с обсуждения различных моделей параллельного программирования, использующих процессы, потоки или асинхронные задачи. Первая глава охватит основные части асинхронной модели Rust, прежде чем мы углубимся в детали асинхронного программирования в второй главе, где мы представим парадигму программирования async/await. Мы рассмотрим ещё несколько концепций асинхронного программирования в следующей главе.

Одной из основных причин использования асинхронного программирования является более производительный ввод-вывод (IO), который мы рассматриваем в следующей главе. Мы также подробно рассматриваем блокировки в той же главе. Блокировка — это серьёзная опасность в асинхронном программировании, когда поток лишается возможности прогрессировать из-за операции (часто ввода-вывода), которая синхронно ожидает.

Другой мотивацией для асинхронного программирования является то, что оно способствует новым моделям абстракции и композиции параллельного кода. После этого мы переходим к синхронизации между параллельными задачами.

Также есть глава, посвящённая инструментам для асинхронного программирования.

Последние несколько глав охватывают более специализированные темы, начиная с асинхронного разрушения и очистки (что является распространённым требованием, но, поскольку в настоящее время нет хорошего встроенного решения, это несколько специализированная тема).

Следующие две главы руководства подробно рассматривают фьючерсы (futures) и среды выполнения (runtimes) — два фундаментальных строительных блока асинхронного программирования.

Наконец, мы рассматриваем таймеры и обработку сигналов, а также асинхронные итераторы (async iterators), также известные как потоки (streams). Последние — это то, как мы программируем работы с последовательностями асинхронных событий (в отличие от отдельных асинхронных событий, которые представлены с помощью фьючерсов или асинхронных функций). Это область, в которой язык активно развивается, и поэтому здесь могут быть некоторые шероховатости.

Параллельное программирование

Цель этой главы — дать вам общее представление о том, как работает асинхронный параллелизм и чем он отличается от параллелизма с использованием потоков. Я считаю важным иметь хорошую ментальную модель происходящего, прежде чем переходить к практическим аспектам, но если вы из тех, кто предпочитает сначала увидеть реальный код, вам может понравиться прочитать следующую главу или две, а затем вернуться к этой.

Мы начнем с некоторой мотивации, затем рассмотрим последовательное выполнение, программирование с потоками или процессами, а затем асинхронное программирование. Глава завершается разделом о параллелизме и конкурентности.

Пользователи хотят, чтобы их компьютеры делали несколько вещей одновременно. Иногда пользователи хотят делать эти вещи в одно и то же время (например, слушать музыку в приложении и одновременно печатать в своем редакторе). Иногда выполнение нескольких задач одновременно более эффективно (например, выполнение некоторой работы в редакторе во время загрузки большого файла). Иногда несколько пользователей хотят использовать один компьютер одновременно (например, несколько клиентов, подключенных к серверу).

Чтобы привести пример более низкого уровня, музыкальной программе, возможно, необходимо продолжать воспроизводить музыку, пока пользователь взаимодействует с пользовательским интерфейсом (UI). Чтобы «продолжать воспроизводить музыку», ей может потребоваться потоковая передача музыкальных данных с сервера, обработка этих данных из одного формата в другой и отправка обработанных данных в аудиосистему компьютера через операционную систему (ОС). Для пользователя ей может потребоваться отправлять и получать данные или команды на сервер в ответ на инструкции пользователя, ей может потребоваться отправлять сигналы подсистеме, воспроизводящей музыку (например, если пользователь меняет трек или ставит на паузу), ей может потребоваться обновлять графический дисплей (например, выделяя кнопку или изменяя название трека), и она должна сохранять отзывчивость курсора мыши или текстовых вводов во время всего вышеперечисленного.

Выполнение нескольких вещей одновременно (или создание такого впечатления) называется конкурентностью (concurrency). Программы (вместе с ОС) должны управлять своей конкурентностью, и есть много способов сделать это. Мы опишем некоторые из этих способов в этой главе, но начнем с чисто последовательного кода, т.е. без какой-либо конкурентности.

Последовательное выполнение

Режимом выполнения по умолчанию в большинстве языков программирования (включая Rust) является последовательное выполнение.

do_a_thing();

println!("hello!");

do_another_thing();

Каждое оператор завершается до начала следующего1. Между этими операторами ничего не происходит2. Это может показаться тривиальным, но это действительно полезное свойство для рассуждений о нашем коде. Однако это также означает, что мы тратим много времени впустую. В приведенном выше примере, пока мы ждем выполнения println!("hello!"), мы могли бы выполнить do_another_thing(). Возможно, мы могли бы даже выполнить все три оператора одновременно.

Всякий раз, когда происходит IO3 (печать с помощью println! — это IO — это вывод текста на консоль через вызов ОС), программа будет ждать завершения IO4, прежде чем выполнить следующий оператор. Ожидание завершения IO перед продолжением выполнения блокирует программу от выполнения другой работы. Блокирующий IO — это самый простой вид IO для использования, реализации и рассуждений, но он также наименее эффективен — в последовательном мире программа не может делать ничего, пока ждет завершения IO.

Процессы и потоки

Процессы и потоки — это концепции, предоставляемые операционной системой для обеспечения конкурентности. На каждый исполняемый файл приходится один процесс, поэтому поддержка нескольких процессов означает, что компьютер может запускать несколько программ5 одновременно; может быть несколько потоков на процесс, что означает, что также может быть конкурентность внутри процесса.

Есть много небольших различий в том, как обрабатываются процессы и потоки. Самое важное различие заключается в том, что память разделяется между потоками, но не между процессами6. Это означает, что общение между процессами происходит посредством передачи сообщений, подобно общению между программами, работающими на разных компьютерах. С точки зрения программы, единственный процесс — это весь их мир; создание новых процессов означает запуск новых программ. Создание новых потоков, однако, является просто частью регулярного выполнения программы.

Из-за этих различий между процессами и потоками они ощущаются программистом по-разному. Но с точки зрения ОС они очень похожи, и мы будем обсуждать их свойства так, как если бы они были единой концепцией. Мы будем говорить о потоках, но если не оговорено иное, вы должны понимать, что это означает «потоки или процессы».

ОС отвечает за планирование потоков, что означает, что она решает, когда потоки запускаются и как долго. Большинство современных компьютеров имеют несколько ядер, поэтому они могут запускать несколько потоков буквально одновременно. Однако обычно потоков намного больше, чем ядер, поэтому ОС будет запускать каждый поток в течение небольшого промежутка времени, затем приостанавливать его и запускать другой поток на некоторое время7. Когда несколько потоков запускаются на одном ядре таким образом, это называется чередованием (interleaving) или разделением времени (time-slicing). Поскольку ОС выбирает, когда приостановить выполнение потока, это называется вытесняющей многозадачностью (pre-emptive multitasking) (многозадачность здесь просто означает одновременное выполнение нескольких потоков); ОС вытесняет (pre-empts) выполнение потока (или, более многословно, ОС вытесняюще приостанавливает выполнение. Она вытесняющая, потому что ОС приостанавливает поток, чтобы освободить время для другого потока, до того, как первый поток иначе приостановился бы, чтобы гарантировать, что второй поток сможет выполниться до того, как станет проблемой, что он не может).

Давайте снова посмотрим на IO. Что происходит, когда поток блокируется в ожидании IO? В системе с потоками ОС приостановит поток (в любом случае он просто будет ждать) и разбудит его снова, когда IO завершится8. В зависимости от алгоритма планирования, может пройти некоторое время после завершения IO, пока ОС разбудит поток, ожидающий IO, поскольку ОС может подождать, пока другие потоки выполнят некоторую работу. Так что теперь все стало намного эффективнее: пока один поток ждет IO, другой поток (или, скорее всего, многие потоки из-за многозадачности) может прогрессировать. Но с точки зрения потока, выполняющего IO, все остается последовательным — он ждет завершения IO, прежде чем начать следующую операцию.

Поток также может добровольно приостановить себя, вызвав функцию sleep, обычно с таймаутом. В этом случае ОС приостанавливает поток по запросу самого потока. Подобно приостановке из-за вытеснения или IO, ОС позже (после таймаута) разбудит поток для продолжения выполнения.

Когда ОС приостанавливает один поток и запускает другой (по любой причине), это называется переключением контекста (context switching). Переключаемый контекст включает регистры, записи операционной системы и содержимое многих кэшей. Это нетривиальный объем работы. Вместе с передачей управления ОС и обратно к потоку и затратами на работу с устаревшими кэшами, переключение контекста является дорогой операцией.

Наконец, обратите внимание, что некоторое оборудование или ОС не поддерживают процессы или потоки, это более вероятно во встроенном мире (embedded).

Асинхронное программирование

Асинхронное программирование — это вид конкурентности с теми же высокоуровневыми целями, что и конкурентность с потоками (делать много вещей одновременно), но с другой реализацией. Два больших различия между асинхронной конкурентностью и конкурентностью с потоками заключаются в том, что асинхронной конкурентностью управляют полностью внутри программы без помощи ОС9, и что многозадачность является кооперативной, а не вытесняющей10 (мы объясним это через минуту). Существует много различных моделей асинхронной конкурентности, мы сравним их позже в руководстве, но сейчас мы сосредоточимся только на модели Rust.

Чтобы отличать их от потоков, мы будем называть последовательность выполнений в асинхронной конкурентности задачей (task) (их также называют зелеными потоками (green threads), но это иногда имеет смысл вытесняющего планирования и деталей реализации, таких как один стек на задачу). Способ выполнения, планирования и представления задачи в памяти очень отличается от потока, но для высокоуровневой интуиции может быть полезно думать о задачах как о потоках, но управляемых полностью внутри программы, а не ОС.

В асинхронной системе все еще есть планировщик (scheduler), который решает, какую задачу запустить следующей (он является частью программы, а не частью ОС). Однако планировщик не может вытеснить задачу. Вместо этого задача должна добровольно отказаться от управления и позволить запланировать другую задачу. Поскольку задачи должны сотрудничать (cooperate) (отказываясь от управления), это называется кооперативной многозадачностью (cooperative multitasking).

Использование кооперативной, а не вытесняющей многозадачности имеет много последствий:

- между точками, где управление может быть уступлено, вы можете гарантировать, что код будет выполняться последовательно — вас никогда не приостановят неожиданно,

- если задача занимает много времени между точками уступки (например, выполняя блокирующий IO или длительные вычисления), другие задачи не смогут прогрессировать,

- реализация планировщика намного проще, и планирование (и переключение контекста) имеет меньше накладных расходов.

Асинхронная конкурентность намного эффективнее конкурентности с потоками. Накладные расходы на память намного ниже, а переключение контекста — гораздо более дешевая операция — оно не требует передачи управления ОС и обратно к программе, и данных для переключения намного меньше. Однако все еще могут быть некоторые эффекты кэширования — хотя кэши ОС, такие как TLB, не нужно менять, задачи, вероятно, работают с разными частями памяти, поэтому данные, требуемые вновь запланированной задачей, могут не находиться в кэше памяти.

Асинхронный IO — это альтернатива блокирующему IO (его иногда называют неблокирующим IO). Асинхронный IO не связан напрямую с асинхронной конкурентностью, но они часто используются вместе. При асинхронном IO программа инициирует IO одним системным вызовом, а затем может либо проверить, либо получить уведомление о завершении IO. Это означает, что программа может свободно выполнять другую работу, пока происходит IO. В Rust механику асинхронного IO обрабатывает асинхронная среда выполнения (runtime) (планировщик также является частью среды выполнения, мы обсудим среды выполнения подробнее позже в этой книге, но, по сути, среда выполнения — это просто библиотека, которая заботится о некоторых фундаментальных асинхронных вещах).

С точки зрения всей системы, блокирующий IO в конкурентной системе с потоками и неблокирующий IO в асинхронной конкурентной системе схожи. В обоих случаях IO занимает время, и другая работа выполняется, пока происходит IO:

- С потоками: поток, выполняющий IO, запрашивает IO у ОС, поток приостанавливается ОС, другие потоки выполняют работу, и когда IO завершен, ОС пробуждает поток, чтобы он мог продолжить выполнение с результатом IO.

- С async: задача, выполняющая IO, запрашивает IO у среды выполнения, среда выполнения запрашивает IO у ОС, но ОС возвращает управление среде выполнения. Среда выполнения приостанавливает задачу IO и планирует другие задачи для выполнения работы. Когда IO завершен, среда выполнения пробуждает задачу IO, чтобы она могла продолжить выполнение с результатом IO.

Преимущество использования асинхронного IO заключается в том, что накладные расходы намного ниже, поэтому система может поддерживать на порядки больше задач, чем потоков. Это делает асинхронную конкурентность особенно хорошо подходящей для задач с большим количеством пользователей, которые проводят много времени в ожидании IO (если они не проводят много времени в ожидании и вместо этого выполняют много работы, ограниченной CPU, то преимущество низких накладных расходов не так велико, потому что узким местом будут ресурсы CPU и памяти).

Потоки и async не исключают друг друга: многие программы используют и то, и другое. Некоторые программы имеют части, которые лучше реализованы с использованием потоков, и части, которые лучше реализованы с использованием async. Например, сервер базы данных может использовать асинхронные техники для управления сетевым общением с клиентами, но использовать потоки ОС для вычислений с данными. Альтернативно, программа может быть написана только с использованием асинхронной конкурентности, но среда выполнения будет выполнять задачи в нескольких потоках. Это необходимо для того, чтобы программа могла использовать несколько ядер CPU. Мы рассмотрим пересечение потоков и асинхронных задач в нескольких местах позже в книге.

Конкурентность и параллелизм

До сих пор мы говорили о конкурентности (concurrency) (делать или казаться делающим много вещей одновременно), и мы намекали на параллелизм (parallelism) (наличие нескольких ядер CPU, что способствует буквальному выполнению многих вещей одновременно). Эти термины иногда используются взаимозаменяемо, но они являются разными концепциями. В этом разделе мы попытаемся точно определить эти термины и разницу между ними. Я буду использовать простой псевдокод для иллюстрации.

Представьте себе одну задачу, разбитую на кучу подзадач:

task1 {

subTask1-1()

subTask1-2()

...

subTask1-100()

}

Давайте представим, что мы процессор, который выполняет такой псевдокод. Очевидный способ сделать это — сначала выполнить subTask1-1, затем выполнить subTask1-2 и так далее, пока мы не выполним все подзадачи. Это последовательное выполнение.

Теперь рассмотрим несколько задач. Как мы могли бы их выполнить? Мы могли бы начать одну задачу, выполнить все подзадачи, пока вся задача не будет завершена, затем начать следующую. Две задачи выполняются последовательно (и подзадачи внутри каждой задачи также выполняются последовательно). Глядя только на подзадачи, вы бы выполнили их так:

subTask1-1()

subTask1-2()

...

subTask1-100()

subTask2-1()

subTask2-2()

...

subTask2-100()

В качестве альтернативы, вы могли бы выполнить subTask1-1, затем отложить task1 (запомнив, как далеко вы продвинулись), взять следующую задачу и выполнить первую подзадачу из нее, затем вернуться к task1, чтобы выполнить следующую подзадачу. Две задачи были бы чередующимися (interleaved), мы называем это конкурентным выполнением двух задач. Это могло бы выглядеть так:

subTask1-1()

subTask2-1()

subTask1-2()

subTask2-2()

...

subTask1-100()

subTask2-100()

Если только одна задача не может наблюдать результаты или побочные эффекты другой задачи, то с точки зрения задачи подзадачи все еще выполняются последовательно.

Нет причин ограничиваться двумя задачами, мы можем чередовать любое количество и делать это в любом порядке.

Обратите внимание, что независимо от того, сколько конкурентности мы добавим, вся работа занимает одинаковое количество времени для завершения (на самом деле, с большей конкурентностью это может занять больше времени из-за накладных расходов на переключение контекста между ними). Однако для данной подзадачи мы можем завершить ее раньше, чем при чисто последовательном выполнении (для пользователя это может ощущаться более отзывчивым).

Теперь представьте, что обрабатываете задачи не только вы, у вас есть друзья-процессоры, чтобы помочь. Вы можете работать над задачами одновременно и выполнять работу быстрее! Это параллельное выполнение (которое также является конкурентным). Вы могли бы выполнять подзадачи так:

Процессор 1 Процессор 2

============== ==============

subTask1-1() subTask2-1()

subTask1-2() subTask2-2()

... ...

subTask1-100() subTask2-100()

Если процессоров больше двух, мы можем обрабатывать еще больше задач параллельно. Мы также могли бы делать некоторое чередование задач на каждом процессоре или разделение задач между процессорами.

В реальном коде все немного сложнее. Некоторые подзадачи (например, IO) не требуют активного участия процессора, им нужно только запуститься, и некоторое время спустя собрать результаты. А некоторые подзадачи могут требовать результаты (или побочные эффекты) подзадачи из другой задачи для продолжения работы (синхронизация). Оба этих сценария ограничивают эффективные способы конкурентного выполнения задач, и именно поэтому, вместе с обеспечением некоторой концепции справедливости, планирование важно.

Достаточно глупых примеров, давайте попробуем определить вещи правильно

Конкурентность (Concurrency) — это про порядок вычислений, а параллелизм (Parallelism) — про режим выполнения.

Для двух вычислений мы говорим, что они последовательны (т.е. не конкурентны), если мы можем наблюдать, что одно происходит до другого, или что они конкурентны, если мы не можем наблюдать (или, альтернативно, не имеет значения), что одно происходит до другого.

Два вычисления происходят параллельно, если они буквально происходят в одно и то же время. Мы можем думать о параллелизме как о ресурсе: чем больше параллелизма доступно, тем больше вычислений может произойти за фиксированный период времени (при условии, что вычисления происходят с той же скоростью). Увеличение конкурентности системы без увеличения параллелизма никогда не может сделать ее быстрее (хотя это может сделать систему более отзывчивой и может сделать возможной реализацию оптимизаций, которые в противном случае были бы непрактичны).

Перефразируя, два вычисления могут происходить одно за другим (ни конкурентно, ни параллельно), их выполнение может быть чередовано на одном ядре CPU (конкурентно, но не параллельно), или они могут выполняться одновременно на двух ядрах (конкурентно и параллельно)11.

Другая полезная формулировка12 заключается в том, что конкурентность — это способ организации кода, а параллелизм — это ресурс. Это мощное утверждение! То, что конкурентность — это про организацию кода, а не выполнение кода, важно, потому что с точки зрения процессора конкурентность без параллелизма просто не существует. Это особенно актуально для асинхронной конкурентности, потому что она реализована полностью в коде пользователя — не только это «всего лишь» про организацию кода, но вы можете легко доказать это себе, просто прочитав исходный код. То, что параллелизм — это ресурс, также полезно, потому что это напоминает нам, что для параллелизма и производительности важно только количество ядер процессора, а не то, как код организован с точки зрения конкурентности (например, сколько потоков).

Как системы с потоками, так и асинхронные системы могут предлагать и конкурентность, и параллелизм. В обоих случаях конкурентность контролируется кодом (порождение потоков или задач), а параллелизм контролируется планировщиком, который является частью ОС для потоков (настраивается через API ОС) и частью библиотеки среды выполнения для async (настраивается выбором среды выполнения, тем, как реализована среда выполнения, и опциями, которые среда выполнения предоставляет клиентскому коду). Однако есть практическое различие из-за соглашений и общих значений по умолчанию. В системах с потоками каждый конкурентный поток выполняется параллельно с использованием как можно большего параллелизма. В асинхронных системах нет строгого значения по умолчанию: система может запускать все задачи в одном потоке, может назначать несколько задач одному потоку и привязывать этот поток к ядру (так что группы задач выполняются параллельно, но внутри группы каждая задача выполняется конкурентно, но никогда параллельно с другими задачами внутри группы), или задачи могут запускаться параллельно с ограничениями или без. Для первой части этого руководства мы будем использовать среду выполнения Tokio, которая в основном поддерживает последнюю модель. Т.е. поведение относительно параллелизма похоже на конкурентность с потоками. Более того, мы увидим функции в асинхронном Rust, которые явно поддерживают конкурентность, но не параллелизм, независимо от среды выполнения.

Резюме

- Существует много моделей выполнения. Мы описали последовательное выполнение, потоки и процессы, и асинхронное программирование.

- Потоки — это абстракция, предоставляемая (и планируемая) ОС. Они обычно включают вытесняющую многозадачность, по умолчанию параллельны и имеют довольно высокие накладные расходы на управление и переключение контекста.

- Асинхронное программирование управляется пользовательской средой выполнения (user-space runtime). Многозадачность кооперативная. Оно имеет более низкие накладные расходы, чем потоки, но ощущается немного иначе, чем программирование с потоками, поскольку использует другие примитивы программирования (

asyncиawait, и фьючерсы (futures), а не потоки как объекты первого класса).

- Конкурентность и параллелизм — это разные, но тесно связанные концепции.

- Конкурентность — это про порядок вычислений (операции конкурентны, если порядок их выполнения нельзя наблюдать).

- Параллелизм — это про вычисления на нескольких процессорах (операции параллельны, если они буквально происходят в одно и то же время).

- И потоки ОС, и асинхронное программирование обеспечивают конкурентность и параллелизм; асинхронное программирование также может предлагать конструкции для гибкой или детализированной конкурентности, которые не являются частью API потоков большинства операционных систем.

-

На самом деле это не совсем так: современные компиляторы и процессоры реорганизуют ваш код и выполняют его в любом порядке, который им нравится. Последовательные операторы, вероятно, будут перекрываться многими различными способами. Однако это никогда не должно быть наблюдаемо для самой программы или ее пользователей. ↩

-

Это тоже не совсем так: даже когда одна программа является чисто последовательной, другие программы могут работать одновременно; подробнее об этом в следующем разделе. ↩

-

IO — это аббревиатура от input/output (ввод/вывод). Это означает любое общение программы с миром вне программы. Это может быть чтение или запись на диск или в сеть, вывод на терминал, получение пользовательского ввода с клавиатуры или мыши или общение с ОС или другой программой, работающей в системе. IO интересен в контексте конкурентности, потому что его выполнение занимает на несколько порядков больше времени, чем почти любая задача, которую программа может выполнять внутри. Это обычно означает много ожидания, и это время ожидания — возможность сделать другую работу. ↩

-

То, когда именно IO завершен, на самом деле довольно сложно. С точки зрения программы, один вызов IO завершен, когда управление возвращается от ОС. Обычно это указывает на то, что данные были отправлены в какое-то оборудование или другую программу, но это не обязательно означает, что данные были фактически записаны на диск или показаны пользователю и т.д. Для этого может потребоваться дополнительная работа в оборудовании или периодическая очистка кэшей, или чтобы другая программа прочитала данные. В основном нам не нужно об этом беспокоиться, но полезно знать. ↩

-

с точки зрения пользователя, одна программа может включать несколько процессов, но с точки зрения ОС каждый процесс — это отдельная программа. ↩

-

Некоторые ОС поддерживают разделение памяти между процессами, но для ее использования требуется специальный подход, и большая часть памяти не является разделяемой. ↩

-

То, как именно ОС выбирает, какой поток запускать и как долго (и на каком ядре), является ключевой частью планирования. Существует множество вариантов, как высокоуровневых стратегий, так и опций для настройки этих стратегий. Принятие правильных решений здесь имеет crucialное значение для хорошей производительности, но это сложно, и мы не будем здесь углубляться. ↩

-

Есть другой вариант: поток может активно ждать (busy wait), просто вращаясь в цикле, пока IO не завершится. Это не очень эффективно, поскольку другие потоки не смогут запуститься, и это необычно для большинства современных систем. Вы можете столкнуться с этим в реализациях блокировок или в очень простых встраиваемых системах. ↩

-

Мы начнем наше объяснение, предполагая, что программа имеет только один поток, но расширим его позже. Вероятно, в системе работают другие процессы, но они реально не влияют на то, как работает асинхронная конкурентность. ↩

-

Есть некоторые языки программирования (или даже библиотеки), которые имеют конкурентность, управляемую внутри программы (без ОС), но с вытесняющим планировщиком, а не полагаясь на сотрудничество между потоками. Go — известный пример. Эти системы не требуют обозначений

asyncиawait, но имеют другие недостатки, включая усложнение взаимодействия с другими языками или ОС и наличие тяжеловесной среды выполнения. Очень ранние версии Rust имели такую систему, но к версии 1.0 от нее не осталось и следа. ↩ -

Может ли вычисление быть параллельным, но не конкурентным? Вроде да, но не факт. Представьте две задачи (a и b), которые состоят из одной подзадачи каждая (1 и 2, принадлежащие a и b, соответственно). Используя синхронизацию, мы не можем начать подзадачу 2, пока подзадача 1 не завершена, и задача a должна ждать завершения подзадачи 2, пока она не завершится. Теперь a и b работают на разных процессорах. Если мы смотрим на задачи как на черные ящики, мы можем сказать, что они работают параллельно, но в некотором смысле они не конкурентны, потому что их порядок полностью определен. Однако, если мы посмотрим на подзадачи, мы можем увидеть, что они ни параллельны, ни конкурентны. ↩

-

Которую, я думаю, предложил Aaron Turon, и она отразилась в некотором дизайне стандартной библиотеки Rust, например, в функции available_parallelism. ↩

Async и Await

В этой главе мы начнем заниматься асинхронным программированием в Rust и познакомимся с ключевыми словами async и await.

async — это аннотация для функций (и других элементов, таких как трейты, к которым мы вернемся позже); await — это оператор, используемый в выражениях. Но прежде чем мы перейдем к этим ключевым словам, нам нужно охватить несколько основных концепций асинхронного программирования в Rust, что следует из обсуждения в предыдущей главе, здесь мы свяжем вещи напрямую с программированием на Rust.

Концепции async в Rust

Среда выполнения (Runtime)

Асинхронными задачами необходимо управлять и планировать их. Обычно задач больше, чем доступных ядер, поэтому их нельзя запустить все сразу. Когда одна задача останавливает выполнение, должна быть выбрана другая для выполнения. Если задача ожидает IO или какое-либо другое событие, ее не следует планировать, но когда это событие завершится, ее следует запланировать. Это требует взаимодействия с ОС и управления работой IO.

Многие языки программирования предоставляют среду выполнения (runtime). Обычно эта среда выполнения делает гораздо больше, чем просто управляет асинхронными задачами — она может управлять памятью (включая сборку мусора), участвовать в обработке исключений, предоставлять уровень абстракции над ОС или даже быть полноценной виртуальной машиной. Rust — это низкоуровневый язык, который стремится к минимальным накладным расходам времени выполнения. Поэтому асинхронная среда выполнения имеет гораздо более ограниченную область действия, чем среды выполнения многих других языков. Также существует множество способов проектирования и реализации асинхронной среды выполнения, поэтому Rust позволяет вам выбрать одну в зависимости от ваших требований, а не предоставляет одну. Это означает, что для начала работы с асинхронным программированием требуется дополнительный шаг.

Помимо запуска и планирования задач, среда выполнения должна взаимодействовать с ОС для управления асинхронным IO. Она также должна предоставлять функциональность таймеров для задач (что пересекается с управлением IO). Не существует строгих правил о том, как должна быть структурирована среда выполнения, но некоторые термины и разделение обязанностей являются общими:

- Реактор (reactor) или цикл событий (event loop) или драйвер (driver) (эквивалентные термины): распределяет события IO и таймеров, взаимодействует с ОС и выполняет низкоуровневое продвижение выполнения вперед.

- Планировщик (scheduler): определяет, когда задачи могут выполняться и на каких потоках ОС.

- Исполнитель (executor) или среда выполнения (runtime): объединяет реактор и планировщик и представляет собой пользовательский API для запуска асинхронных задач; среда выполнения (runtime) также используется для обозначения всей библиотеки функциональности (например, всего в крейте Tokio, а не только исполнителя Tokio, который представлен типом

Runtime).

Помимо исполнителя, как описано выше, крейт среды выполнения обычно включает множество вспомогательных трейтов и функций. Они могут включать трейты (например, AsyncRead) и реализации для IO, функциональность для распространенных задач IO, таких как сетевое взаимодействие или доступ к файловой системе, блокировки, каналы и другие примитивы синхронизации, утилиты для работы со временем, утилиты для работы с ОС (например, обработка сигналов), вспомогательные функции для работы с фьючерсами и потоками (асинхронные итераторы) или инструменты мониторинга и наблюдения. Мы рассмотрим многие из них в этом руководстве.

Существует множество асинхронных сред выполнения на выбор. Некоторые имеют очень разные политики планирования или оптимизированы для конкретной задачи или области. Для большей части этого руководства мы будем использовать среду выполнения Tokio. Это универсальная среда выполнения, и она является самой популярной в экосистеме. Это отличный выбор для начала работы и для production-использования. В некоторых обстоятельствах вы можете получить лучшую производительность или иметь возможность написать более простой код с другой средой выполнения. Позже в этом руководстве мы обсудим некоторые другие доступные среды выполнения и почему вы можете выбрать ту или иную, или даже написать свою собственную.

Чтобы начать работать как можно быстрее, вам нужно совсем немного шаблонного кода. Вам нужно включить крейт Tokio как зависимость в ваш Cargo.toml (как и любой другой крейт):

[dependencies]

tokio = { version = "1", features = ["full"] }

И вы будете использовать аннотацию tokio::main для вашей функции main, чтобы она могла быть асинхронной функцией (что в противном случае не разрешено в Rust):

#[tokio::main] async fn main() { ... }

Вот и все! Вы готовы писать асинхронный код!

Аннотация #[tokio::main] инициализирует среду выполнения Tokio и запускает асинхронную задачу для выполнения кода в main. Позже в этом руководстве мы подробнее объясним, что делает эта аннотация и как использовать асинхронный код без нее (что даст вам больше гибкости).

Futures-rs и экосистема

TODO контекст и история, для чего нужен futures-rs — раньше использовался часто, сейчас, вероятно, не нужен, пересечение с Tokio и другими средами выполнения (иногда с тонкими семантическими различиями), почему он может вам понадобиться (работа с фьючерсами напрямую, особенно написание своих, потоки (streams), некоторые утилиты)

Другие вещи экосистемы — крейты Yosh, альтернативные среды выполнения, экспериментальные вещи, другие?

Фьючерсы и задачи

Базовой единицей асинхронной конкурентности в Rust является фьючерс (future). Фьючерс — это просто обычный старый объект Rust (обычно структура или перечисление), который реализует трейт 'Future'. Фьючерс представляет отложенное вычисление. То есть вычисление, которое будет готово в какой-то момент в будущем.

Мы много будем говорить о фьючерсах в этом руководстве, но проще начать, не слишком беспокоясь о них. Мы будем упоминать их довольно часто в следующих нескольких разделах, но мы не будем на самом деле определять их или использовать напрямую до конца. Один важный аспект фьючерсов заключается в том, что их можно комбинировать, чтобы создавать новые, «большие» фьючерсы (мы поговорим подробнее о том, как их можно комбинировать позже).

Я довольно неформально использовал термин «асинхронная задача» в предыдущей главе и этой. Я использовал этот термин для обозначения логической последовательности выполнения; аналогично потоку, но управляемому внутри программы, а не извне ОС. Часто полезно думать в терминах задач, однако в самом Rust нет концепции задачи, и этот термин используется для обозначения разных вещей! Это сбивает с толку! Что еще хуже, среды выполнения имеют концепцию задачи, и разные среды выполнения имеют немного разные концепции задач.

Отныне я буду стараться быть точным в терминологии, касающейся задач. Когда я использую просто «задача» (task), я имею в виду абстрактную концепцию последовательности вычислений, которая может происходить конкурентно с другими задачами. Я буду использовать «асинхронная задача» (async task) для обозначения точно того же, но в противопоставление задаче, реализованной как поток ОС. Я буду использовать «задача среды выполнения» (runtime's task) для обозначения любого вида задачи, которую представляет себе среда выполнения, и «задача tokio» (tokio task) (или какой-либо другой конкретной среды выполнения) для обозначения концепции задачи в Tokio.

Асинхронная задача в Rust — это просто фьючерс (обычно «большой» фьючерс, составленный из многих других). Другими словами, задача — это фьючерс, который выполняется. Однако бывают случаи, когда фьючерс «выполняется», не будучи задачей среды выполнения. Такой фьючерс интуитивно является задачей, но не задачей среды выполнения. Я уточню это, когда мы дойдем до примера.

Асинхронные функции

Ключевое слово async является модификатором для объявлений функций. Например, мы можем написать pub async fn send_to_server(...). Асинхронная функция — это просто функция, объявленная с использованием ключевого слова async, и это означает, что это функция, которая может выполняться асинхронно, другими словами, вызывающая сторона может выбрать не ждать завершения функции перед выполнением чего-то другого.

Более механически, когда асинхронная функция вызывается, тело не выполняется, как это было бы для обычной функции. Вместо этого тело функции и ее аргументы упаковываются в фьючерс, который возвращается вместо реального результата. Вызывающая сторона может затем решить, что делать с этим фьючерсом (если вызывающей стороне нужен результат «немедленно», то она будет awaitить фьючерс, см. следующий раздел).

Внутри асинхронной функции код выполняется обычным, последовательным образом1, асинхронность не меняет этого. Вы можете вызывать синхронные функции из асинхронных функций, и выполнение продолжается как обычно. Одна дополнительная вещь, которую вы можете делать внутри асинхронной функции, — использовать await для ожидания других асинхронных функций (или фьючерсов), что может привести к уступке управления, чтобы другая задача могла выполниться.

await

Мы заявили выше, что фьючерс — это вычисление, которое будет готово в какой-то момент в будущем. Чтобы получить результат этого вычисления, мы используем ключевое слово await. Если результат готов немедленно или может быть вычислен без ожидания, то await просто выполняет это вычисление для получения результата. Однако, если результат не готов, то await передает управление планировщику, чтобы другая задача могла продолжить (это кооперативная многозадачность, упомянутая в предыдущей главе).

Синтаксис использования await — some_future.await, т.е. это постфиксное ключевое слово, используемое с оператором .. Это означает, что его можно эргономично использовать в цепочках вызовов методов и обращений к полям.

Рассмотрим следующие функции:

#![allow(unused)] fn main() { // Асинхронная функция, но ей не нужно ничего ждать. async fn add(a: u32, b: u32) -> u32 { a + b } async fn wait_to_add(a: u32, b: u32) -> u32 { sleep(1000).await; a + b } }

Если мы вызовем add(15, 3).await, то он немедленно вернет результат 18. Если мы вызовем wait_to_add(15, 3).await, мы в конечном итоге получим тот же ответ, но пока мы ждем, другая задача получит возможность запуститься.

В этом глупом примере вызов sleep является заменой выполнения какой-то длительной задачи, где нам приходится ждать результата. Обычно это операция IO, где результатом являются данные, прочитанные из внешнего источника, или подтверждение того, что запись во внешнее место назначения удалась. Чтение выглядит примерно так: let data = read(...).await?. В этом случае await заставит текущую задачу ждать, пока происходит чтение. Задача возобновит работу, когда чтение будет завершено (другие задачи могут выполнить некоторую работу, пока задача чтения ждет). Результатом чтения могут быть успешно прочитанные данные или ошибка (обрабатываемая оператором ?).

Обратите внимание, что если мы вызовем add или wait_to_add или read без использования .await, мы не получим никакого ответа!

Что?

Вызов асинхронной функции возвращает фьючерс, он не выполняет немедленно код внутри функции. Более того, фьючерс не выполняет никакой работы, пока его не await2. Это контрастирует с некоторыми другими языками, где асинхронная функция возвращает фьючерс, который начинает выполняться немедленно.

Это важный момент в асинхронном программировании на Rust. Через некоторое время это станет второй натурой, но это часто сбивает с толку начинающих, особенно тех, у кого есть опыт асинхронного программирования на других языках.

Важная интуиция о фьючерсах в Rust заключается в том, что они инертны. Чтобы выполнить какую-либо работу, их должно продвигать вперед внешняя сила (обычно асинхронная среда выполнения).

Мы описали await довольно операционно (он запускает фьючерс, производя результат), но мы говорили в предыдущей главе об асинхронных задачах и конкурентности, как await вписывается в эту ментальную модель? Во-первых, рассмотрим чисто последовательный код: логически, вызов функции просто выполняет код в функции (с некоторым присваиванием переменных). Другими словами, текущая задача продолжает выполнять следующий «кусок» кода, определенный функцией. Аналогично, в асинхронном контексте вызов неасинхронной функции просто продолжает выполнение с этой функции. Вызов асинхронной функции находит код для выполнения, но не выполняет его. await — это оператор, который продолжает выполнение текущей задачи, или, если текущая задача не может продолжить прямо сейчас, дает другой задаче возможность продолжить.

await может использоваться только внутри асинхронного контекста, пока это означает внутри асинхронной функции (позже мы увидим больше видов асинхронных контекстов). Чтобы понять почему, вспомните, что await может передавать управление среде выполнения, чтобы другая задача могла выполниться. Среда выполнения, которой можно передать управление, существует только в асинхронном контексте. Пока вы можете представить среду выполнения как глобальную переменную, доступную только в асинхронных функциях, позже мы объясним, как это работает на самом деле.

Наконец, для еще одной перспективы на await: мы упомянули ранее, что фьючерсы можно комбинировать, чтобы создавать «большие» фьючерсы. Асинхронные функции — это один из способов определить фьючерс, а await — один из способов комбинировать фьючерсы. Использование await на фьючерсе объединяет этот фьючерс в фьючерс, производимый асинхронной функцией, внутри которой он используется. Мы поговорим подробнее об этой перспективе и других способах комбинирования фьючерсов позже.

Некоторые примеры async/await

Давайте начнем с повторного посещения нашего примера «Hello, world!»:

// Define an async function. async fn say_hello() { println!("hello, world!"); } #[tokio::main] // Boilerplate which lets us write `async fn main`, we'll explain it later. async fn main() { // Call an async function and await its result. say_hello().await; }

Теперь вы должны узнавать шаблонный код вокруг main. Он нужен для инициализации среды выполнения Tokio и создания начальной задачи для запуска асинхронной функции main.

say_hello — это асинхронная функция, когда мы вызываем ее, мы должны следовать за вызовом .await, чтобы запустить ее как часть текущей задачи. Обратите внимание, что если вы удалите .await, то запуск программы ничего не делает! Вызов say_hello возвращает фьючерс, но он никогда не выполняется, поэтому println никогда не вызывается (компилятор, по крайней мере, предупредит вас).

Вот немного более реалистичный пример, взятый из учебника Tokio.

#[tokio::main] async fn main() -> Result<()> { // Открываем соединение с адресом mini-redis. let mut client = client::connect("127.0.0.1:6379").await?; // Устанавливаем ключ "hello" со значением "world" client.set("hello", "world".into()).await?; // Получаем ключ "hello" let result = client.get("hello").await?; println!("got value from the server; result={:?}", result); Ok(()) }

Код немного интереснее, но мы essentially делаем то же самое — вызываем асинхронные функции, а затем ожидаем (await) выполнения результата. На этот раз мы используем ? для обработки ошибок — это работает так же, как в синхронном Rust.

При всей нашей болтовне о конкурентности, параллелизме и асинхронности, оба этих примера на 100% последовательны. Простой вызов и ожидание асинхронных функций не вводят никакой конкурентности, если нет других задач для планирования, пока ожидающая задача ждет. Чтобы доказать это себе, давайте посмотрим на другой простой (но надуманный) пример:

use std::io::{stdout, Write}; use tokio::time::{sleep, Duration}; async fn say_hello() { print!("hello, "); // Flush stdout so we see the effect of the above `print` immediately. stdout().flush().unwrap(); } async fn say_world() { println!("world!"); } #[tokio::main] async fn main() { say_hello().await; // An async sleep function, puts the current task to sleep for 1s. sleep(Duration::from_millis(1000)).await; say_world().await; }

Между выводом "hello" и "world" мы усыпляем текущую задачу3 на одну секунду. Наблюдайте, что происходит при запуске программы: она печатает "hello", ничего не делает в течение одной секунды, затем печатает "world". Это потому, что выполнение одной задачи является чисто последовательным. Если бы у нас была какая-то конкурентность, то эта одна секунда сна была бы отличной возможностью сделать другую работу, например, напечатать "world". Мы увидим, как это сделать, в следующем разделе.

Порождение задач (Spawning tasks)

Мы говорили об async и await как о способе запуска кода в асинхронной задаче. И мы сказали, что await может усыпить текущую задачу, пока она ждет IO или какое-либо другое событие. Когда это происходит, другая задача может запуститься, но откуда берутся эти другие задачи? Так же, как мы используем std::thread::spawn для порождения новой задачи, мы можем использовать tokio::spawn для порождения новой асинхронной задачи. Обратите внимание, что spawn — это функция Tokio, среды выполнения, а не из стандартной библиотеки Rust, потому что задачи — это чисто концепция среды выполнения.

Вот крошечный пример запуска асинхронной функции в отдельной задаче с помощью spawn:

use tokio::{spawn, time::{sleep, Duration}}; async fn say_hello() { // Wait for a while before printing to make it a more interesting race. sleep(Duration::from_millis(100)).await; println!("hello"); } async fn say_world() { sleep(Duration::from_millis(100)).await; println!("world!"); } #[tokio::main] async fn main() { spawn(say_hello()); spawn(say_world()); // Wait for a while to give the tasks time to run. sleep(Duration::from_millis(1000)).await; }

Аналогично последнему примеру, у нас есть две функции, печатающие "hello" и "world!". Но на этот раз мы запускаем их конкурентно (и параллельно), а не последовательно. Если вы запустите программу несколько раз, вы должны увидеть, что строки печатаются в обоих порядках — иногда сначала "hello", иногда сначала "world!". Классическая гонка в конкурентном программировании!

Давайте углубимся в то, что здесь происходит. В игре три концепции: фьючерсы, задачи и потоки. Функция spawn принимает фьючерс (который, помните, может состоять из многих более мелких фьючерсов) и запускает его как новую задачу Tokio. Задачи — это концепция, которую среда выполнения Tokio планирует и управляет (не отдельными фьючерсами). Tokio (в своей конфигурации по умолчанию) — это многопоточная среда выполнения, что означает, что когда мы порождаем новую задачу, эта задача может быть запущена на другом потоке ОС, чем задача, из которой она была порождена (она может быть запущена на том же потоке, или она может начаться на одном потоке, а затем быть перемещена на другой позже).

Итак, когда фьючерс порождается как задача, он выполняется конкурентно с задачей, из которой он был порожден, и любыми другими задачами. Он также может выполняться параллельно этим задачам, если он запланирован на другом потоке.

Подводя итог, когда мы пишем два оператора, следующих друг за другом в Rust, они выполняются последовательно (независимо от того, в асинхронном коде или нет). Когда мы пишем await, это не меняет конкурентность последовательных операторов. Например, foo(); bar(); строго последовательно — foo вызывается, а затем bar. Это верно, независимо от того, являются ли foo и bar асинхронными функциями или нет. foo().await; bar().await; также строго последовательно, foo полностью вычисляется, а затем bar полностью вычисляется. В обоих случаях другой поток может чередоваться с последовательным выполнением, и во втором случае другая асинхронная задача может чередоваться в точках await, но два оператора выполняются последовательно по отношению друг к другу в обоих случаях.

Если мы используем либо thread::spawn, либо tokio::spawn, мы вводим конкурентность и потенциально параллелизм, в первом случае между потоками, а во втором — между задачами.

Позже в руководстве мы увидим случаи, когда мы выполняем фьючерсы конкурентно, но никогда параллельно.

Соединение задач (Joining tasks)

Если мы хотим получить результат выполнения порожденной задачи, то порождающая задача может ждать ее завершения и использовать результат, это называется соединением (joining) задач (аналогично соединению потоков, и API для соединения похожи).

Когда задача порождается, функция spawn возвращает JoinHandle. Если вы просто хотите, чтобы задача выполняла свою работу, JoinHandle можно отбросить (удаление JoinHandle не влияет на порожденную задачу). Но если вы хотите, чтобы порождающая задача ждала завершения порожденной задачи, а затем использовала результат, вы можете awaitить JoinHandle, чтобы сделать это.

Например, давайте еще раз пересмотрим наш пример «Hello, world!»:

use tokio::{spawn, time::{sleep, Duration}}; async fn say_hello() { // Wait for a while before printing to make it a more interesting race. sleep(Duration::from_millis(100)).await; println!("hello"); } async fn say_world() { sleep(Duration::from_millis(100)).await; println!("world"); } #[tokio::main] async fn main() { let handle1 = spawn(say_hello()); let handle2 = spawn(say_world()); let _ = handle1.await; let _ = handle2.await; println!("!"); }

Код похож на прошлый раз, но вместо простого вызова spawn мы сохраняем возвращенные JoinHandle и позже awaitим их. Поскольку мы ждем завершения этих задач перед выходом из функции main, нам больше не нужен sleep в main.

Две порожденные задачи все еще выполняются конкурентно. Если вы запустите программу несколько раз, вы должны увидеть оба порядка. Однако awaitенные join handles являются ограничением на конкурентность: восклицательный знак ('!') всегда будет напечатан последним (вы можете поэкспериментировать с перемещением println!("!"); относительно await. Вам, вероятно, также нужно будет изменить время сна, чтобы получить наблюдаемые эффекты).

Если бы мы сразу выполнили awaitили JoinHandle первого spawn вместо того, чтобы сохранить его и позже awaitить (т.е. написали spawn(say_hello()).await;), то мы бы породили другую задачу для запуска фьючерса 'hello', но порождающая задача ждала бы ее завершения, прежде чем делать что-либо еще. Другими словами, не было бы возможной конкурентности! Вы почти никогда не захотите делать это (потому что зачем тогда вообще spawn? Просто напишите последовательный код).

JoinHandle

Мы быстро рассмотрим JoinHandle немного глубже. Тот факт, что мы можем awaitить JoinHandle, является подсказкой, что JoinHandle сам по себе является фьючерсом. spawn — это не async функция, это обычная функция, которая возвращает фьючерс (JoinHandle). Она выполняет некоторую работу (для планирования задачи) перед возвратом фьючерса (в отличие от асинхронного фьючерса), поэтому нам не нужно awaitить spawn. Ожидание JoinHandle ждет завершения порожденной задачи, а затем возвращает результат. В приведенном выше примере не было результата, мы просто ждали завершения задачи. JoinHandle — это обобщенный тип, и его параметр типа — это тип, возвращаемый порожденной задачей. В приведенном выше примере тип был бы JoinHandle<()>, фьючерс, который дает String, производил бы JoinHandle с типом JoinHandle<String>.

awaitение JoinHandle возвращает Result (поэтому мы использовали let _ = ... в приведенном выше примере, это избегает предупреждения о неиспользуемом Result). Если порожденная задача завершилась успешно, то результат задачи будет в варианте Ok. Если задача запаниковала или была прервана (форма отмены), то результат будет Err, содержащий тип JoinError. Если вы не используете отмену через abort в своем проекте, то unwrapping результата JoinHandle.await является разумным подходом, поскольку это effectively распространяет панику из порожденной задачи в порождающую задачу.

-

как и любой другой поток, поток, на котором выполняется асинхронная функция, может быть вытеснен (pre-empted) операционной системой и приостановлен, чтобы другой поток мог выполнить некоторую работу. Однако с точки зрения функции это не наблюдается без проверки данных, которые могли быть изменены другими потоками (и которые могли быть изменены другим потоком, выполняющимся параллельно без приостановки текущего потока). ↩

-

Или опрошен (polled), что является операцией более низкого уровня, чем

await, и происходит за кулисами при использованииawait. Мы поговорим об опросе позже, когда будем подробно говорить о фьючерсах. ↩ -

Обратите внимание, что здесь мы используем асинхронную функцию сна, если бы мы использовали

sleepиз std, мы бы усыпили весь поток. Это не имело бы никакого значения в этом игрушечном примере, но в реальной программе это означало бы, что другие задачи не могут быть запланированы на этом потоке в течение этого времени. Это очень плохо. ↩

Дополнительные темы по async/await

Модульные тесты (Unit tests)

Как писать модульные тесты для асинхронного кода? Проблема в том, что await можно использовать только внутри асинхронного контекста, а модульные тесты в Rust по умолчанию не являются асинхронными. К счастью, большинство сред выполнения предоставляют удобные атрибуты для тестов, аналогичные атрибуту для async main. При использовании Tokio это выглядит так:

#![allow(unused)] fn main() { #[tokio::test] async fn test_something() { // Пишите тест здесь, включая все нужные вам `await`. } }

Существует множество способов настройки теста, подробности см. в документации.

Атрибут #[tokio::test] автоматически создает среду выполнения Tokio для выполнения асинхронного теста. Это позволяет использовать .await внутри тестовой функции так же, как и в обычном асинхронном коде.

Для тестирования асинхронных функций, которые могут возвращать ошибки, вы можете использовать assert!(result.is_ok()) или assert!(result.is_err()) для проверки результата Result.

#![allow(unused)] fn main() { #[tokio::test] async fn test_fetch_data_error() { let invalid_url = "https://invalid-url"; let result = fetch_data(invalid_url).await; assert!(result.is_err()); } }

Более сложные темы тестирования асинхронного кода (например, тестирование на состояние гонки, взаимоблокировки и т.д.) будут рассмотрены позже в этом руководстве.

Блокировки и отмена (Cancellation)

Блокировки и отмена — это важные концепции, которые необходимо учитывать при программировании на асинхронном Rust. Это не особенности конкретных функций, а повсеместные свойства системы, которые вы должны понимать, чтобы писать корректный код.

Блокирующий IO (Blocking IO)

Мы говорим, что поток (здесь речь идет о потоках ОС, а не об асинхронных задачах) заблокирован, когда он не может делать прогресс. Обычно это происходит потому, что он ожидает завершения задачи от ОС (чаще всего операции ввода-вывода). Важно, что пока поток заблокирован, ОС знает, что его не нужно планировать, чтобы другие потоки могли работать. Это нормально в многопоточной программе, так как позволяет другим потокам работать, пока заблокированный поток ожидает. Однако в асинхронной программе есть другие задачи, которые должны быть запланированы на том же потоке ОС, но ОС ничего о них не знает и заставляет весь поток ожидать. Это означает, что вместо одной задачи, ожидающей завершения своего IO (что нормально), ждать вынуждены многие задачи (что уже плохо).

Скоро мы поговорим о неблокирующем/асинхронном IO. Пока просто знайте, что неблокирующий IO — это IO, о котором знает асинхронная среда выполнения, и поэтому ждать будет только текущая задача, а поток не будет заблокирован. Крайне важно использовать в асинхронной задаче только неблокирующий IO, и никогда — блокирующий IO (который является единственным видом, предоставляемым стандартной библиотекой Rust).

Блокирующие вычисления (Blocking computation)

Вы также можете заблокировать поток, выполняя вычисления (это не совсем то же самое, что блокирующий IO, поскольку ОС не участвует, но эффект схож). Если у вас есть длительное вычисление (с блокирующим IO или без него) без уступки управления среде выполнения, то эта задача никогда не даст планировщику среды выполнения шанс запланировать другие задачи. Помните, что асинхронное программирование использует кооперативную многозадачность. Здесь задача не сотрудничает, поэтому другие задачи не получат возможности выполнить свою работу. Способы решения этой проблемы мы обсудим позже.

Существует множество других способов заблокировать целый поток, и мы еще не раз вернемся к теме блокировок в этом руководстве.

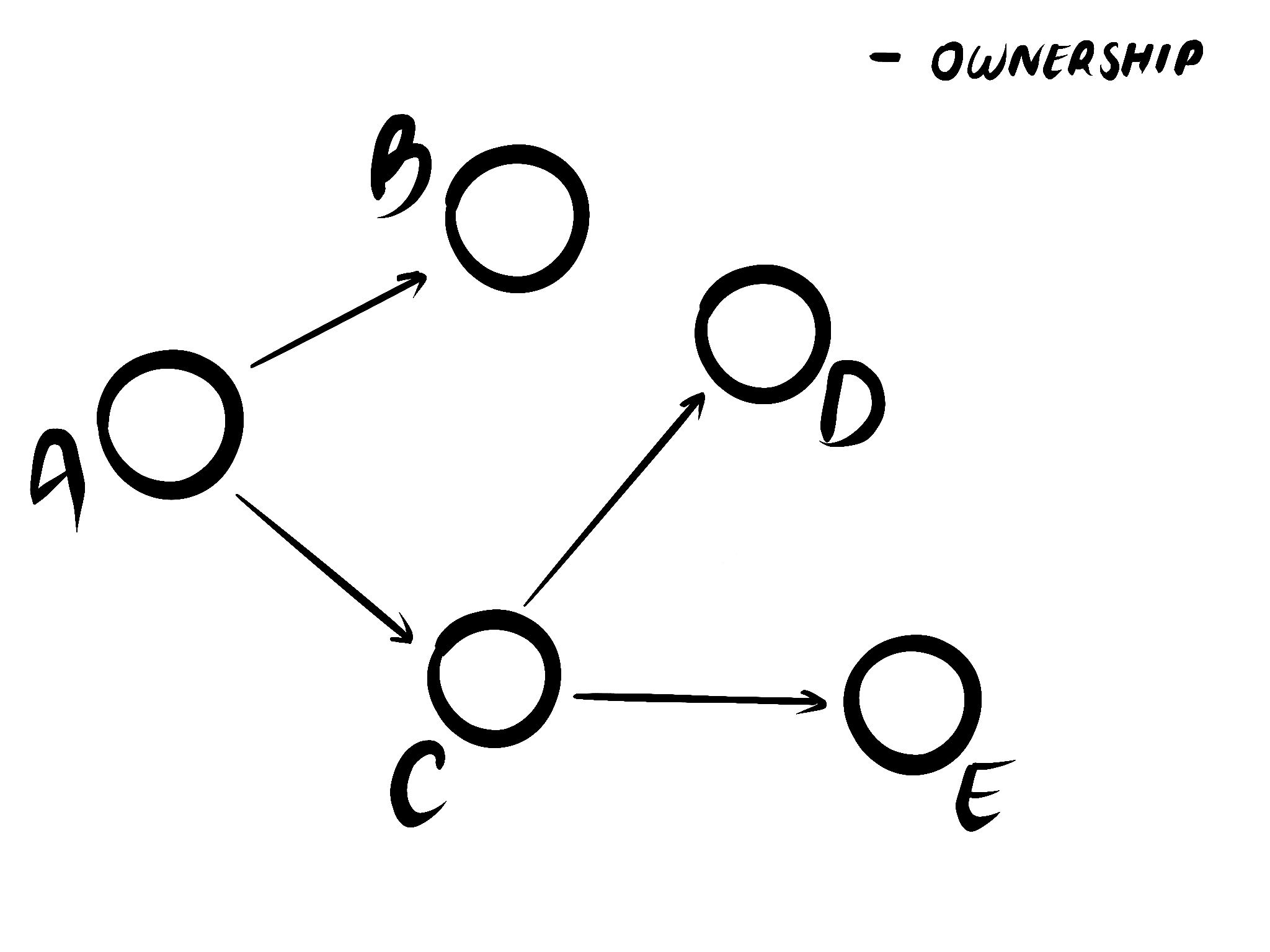

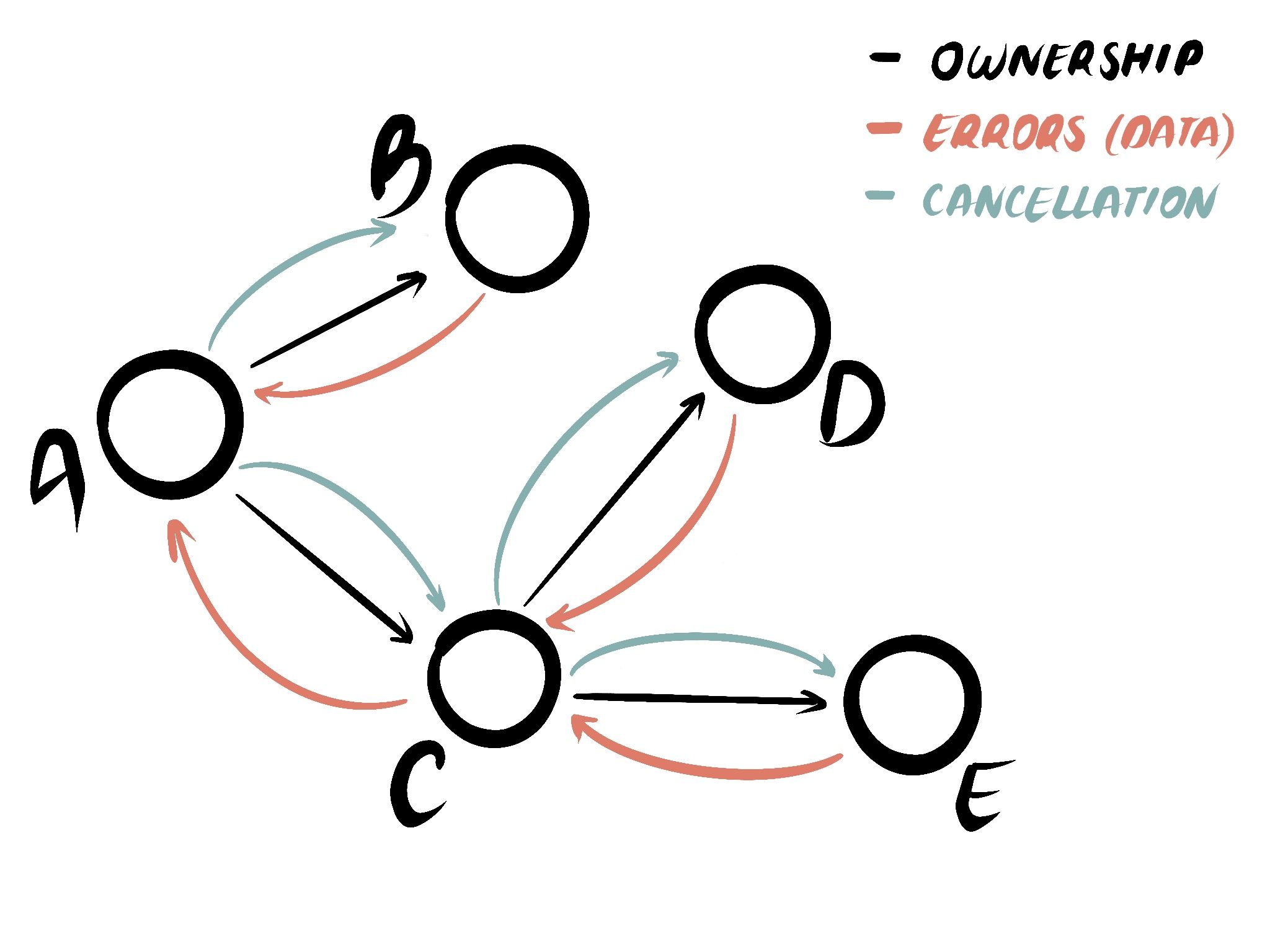

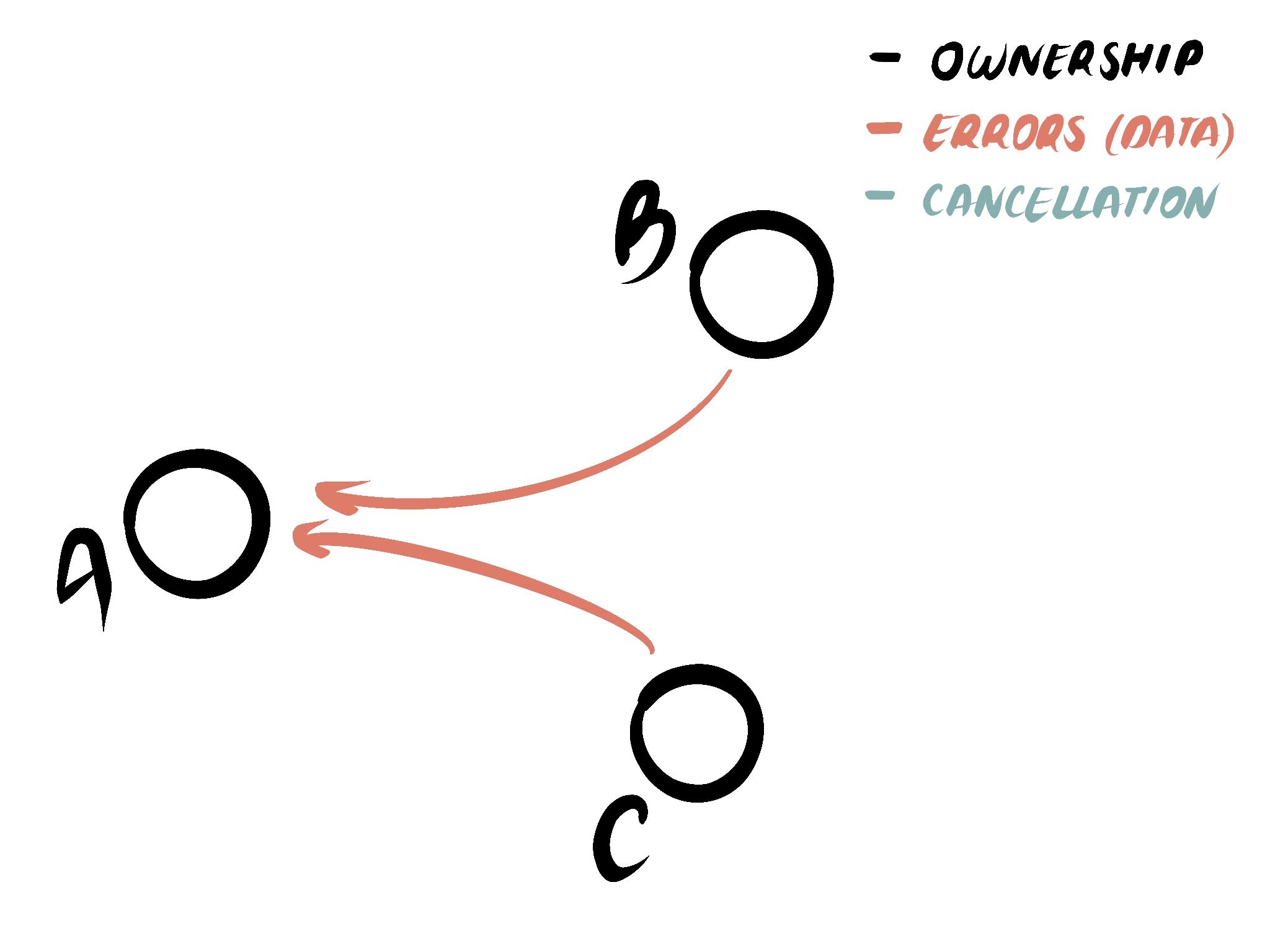

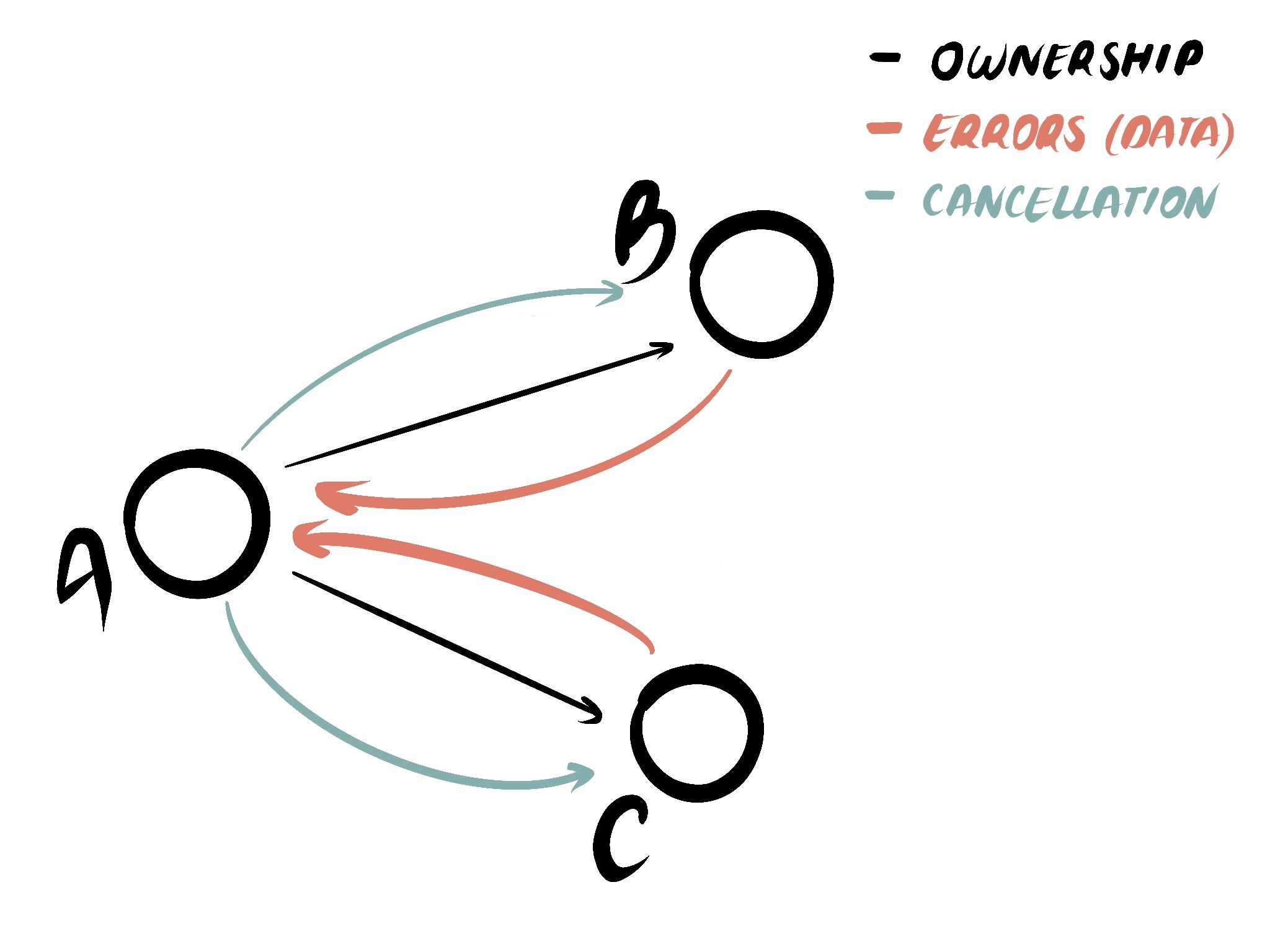

Отмена (Cancellation)

Отмена означает остановку выполнения фьючерса (или задачи). Поскольку в Rust (в отличие от многих других систем async/await) фьючерсы должны продвигаться вперед внешней силой (например, асинхронной средой выполнения), если фьючерс больше не продвигается, то он не будет выполняться. Если фьючерс удаляется (помните, фьючерс — это просто обычный старый объект Rust), то он больше не может делать прогресс и считается отмененным.

Инициировать отмену можно несколькими способами:

- Простым удалением фьючерса (если он вам принадлежит).

- Вызовом

abortуJoinHandleзадачи (или использованиемAbortHandle). - Через

CancellationToken(что требует, чтобы отменяемый фьючерс отслеживал токен и кооперативно отменял сам себя). - Неявно, с помощью функции или макроса, такого как

select.

Второй и третий способы специфичны для Tokio, хотя большинство сред выполнения предоставляют аналогичные возможности. Использование CancellationToken требует сотрудничества со стороны отменяемого фьючерса, а другие способы — нет. В этих других случаях отмененный фьючерс не получит уведомления об отмене и не получит возможности очистить ресурсы (кроме своего деструктора). Обратите внимание, что даже если у фьючерса есть токен отмены, он все равно может быть отменен другими методами, которые не активируют этот токен.

С точки зрения написания асинхронного кода (в асинхронных функциях, блоках, фьючерсах и т.д.), код может остановить выполнение в любой точке await (включая скрытые внутри макросов) и никогда больше не возобновить его. Чтобы ваш код был корректным (в частности, безопасным к отмене - cancellation safe), он должен работать правильно как при нормальном завершении, так и при завершении в любой точке await1.

#![allow(unused)] fn main() { async fn some_function(input: Option<Input>) { let Some(input) = input else { return; // Может завершиться здесь (`return`). }; let x = foo(input)?; // Может завершиться здесь (`?`). let y = bar(x).await; // Может завершиться здесь (`await`). // ... // Может завершиться здесь (неявный return). } }

Пример того, как это может пойти не так: если асинхронная функция читает данные во внутренний буфер, а затем ожидает (await) следующий фрагмент данных. Если чтение данных является деструктивным (т.е. их нельзя перечитать из исходного источника) и асинхронная функция отменена, то внутренний буфер будет удален, и данные в нем будут потеряны. Важно учитывать, как на фьючерс и любые данные, к которым он обращается, повлияет отмена фьючерса, его перезапуск или запуск нового фьючерса, который обращается к тем же данным.

Мы еще несколько раз вернемся к отмене и безопасности отмены в этом руководстве, а в справочном разделе есть целая глава, посвященная этой теме.

Асинхронные блоки (Async blocks)

Обычный блок ({ ... }) группирует код в исходном тексте и создает область видимости для имен. Во время выполнения блок выполняется по порядку и вычисляется в значение своего последнего выражения (или в тип-единицу (), если завершающего выражения нет).

Подобно асинхронным функциям, асинхронный блок — это отложенная версия обычного блока. Асинхронный блок группирует код и имена, но во время выполнения он не выполняется немедленно и вычисляется в фьючерс. Чтобы выполнить блок и получить результат, его необходимо awaitить. Например:

#![allow(unused)] fn main() { let s1 = { let a = 42; format!("The answer is {a}") }; let s2 = async { let q = question().await; format!("The question is {q}") }; }

Если бы мы выполнили этот фрагмент, s1 была бы строкой, которую можно напечатать, а s2 была бы фьючерсом; question() даже не была бы вызвана. Чтобы напечатать s2, нам сначала нужно сделать s2.await.

Асинхронный блок — это простейший способ начать асинхронный контекст и создать фьючерс. Он обычно используется для создания небольших фьючерсов, которые используются только в одном месте.

К сожалению, управление потоком выполнения с асинхронными блоками немного своеобразно. Поскольку асинхронный блок создает фьючерс, а не выполняется напрямую, он ведет себя больше как функция, чем обычный блок, с точки зрения управления потоком. break и continue не могут «пройти сквозь» асинхронный блок, как это бывает с обычными блоками; вместо этого вам придется использовать return:

#![allow(unused)] fn main() { loop { { if ... { // ok continue; } } async { if ... { // не ok // continue; // ok - продолжает со следующей итерации `loop`, хотя учтите, что если бы в цикле после // асинхронного блока был код, он бы выполнился. return; } }.await } }

Чтобы реализовать break, вам нужно будет проверить значение блока (распространенной идиомой является использование ControlFlow для значения блока, что также позволяет использовать ?).

Аналогично, ? внутри асинхронного блока завершит выполнение фьючерса при ошибке, в результате чего awaitенный блок примет значение ошибки, но не выйдет из окружающей функции (как это сделал бы ? в обычном блоке). Для этого вам понадобится еще один ? после await:

#![allow(unused)] fn main() { async { let x = foo()?; // Этот `?` выходит только из асинхронного блока, а не из окружающей функции. consume(x); Ok(()) }.await? }

Раздражает, что это часто сбивает с толку компилятор, поскольку (в отличие от функций) «возвращаемый» тип асинхронного блока не указан явно. Вам, вероятно, потребуется добавить некоторые аннотации типов к переменным или использовать турбо-рыбу (turbofish) для указания типов, например, Ok::<_, MyError>(()) вместо Ok(()) в приведенном выше примере.

Функция, возвращающая асинхронный блок, довольно похожа на асинхронную функцию. Написание async fn foo() -> ... { ... } примерно эквивалентно fn foo() -> ... { async { ... } }. Фактически, с точки зрения вызывающей стороны они эквивалентны, и переход от одной формы к другой не является критическим изменением. Более того, вы можете переопределить одну другой при реализации асинхронного трейта (см. ниже). Однако вам придется скорректировать тип, сделав Future явным в версии с асинхронным блоком: async fn foo() -> Foo становится fn foo() -> impl Future<Output = Foo> (вам также, возможно, потребуется сделать явными другие ограничения, например, Send и 'static).

Обычно следует предпочитать версию с асинхронной функцией, поскольку она проще и понятнее. Однако версия с асинхронным блоком более гибкая, поскольку вы можете выполнить некоторый код при вызове функции (написав его вне асинхронного блока) и некоторый код, когда результат ожидается (код внутри асинхронного блока).

Асинхронные замыкания (Async closures)

- Замыкания

- Скоро будет (https://github.com/rust-lang/rust/pull/132706, https://blog.rust-lang.org/inside-rust/2024/08/09/async-closures-call-for-testing.html)

- Асинхронные блоки в замыканиях против асинхронных замыканий

Время жизни и заимствование (Lifetimes and borrowing)

- Упоминалось о времени жизни

'staticвыше - Ограничения времени жизни для фьючерсов (

Future + '_и т.д.) - Заимствование across await points

- Я не знаю, я уверен, что с асинхронными функциями есть еще проблемы с временем жизни...

Ограничения Send + 'static на фьючерсах

- Почему они там есть, многопоточные среды выполнения

spawn_local, чтобы избежать их- Что делает асинхронную функцию

Send + 'staticи как исправлять ошибки с этим связанные

Асинхронные трейты (Async traits)

- Синтаксис

- Проблема с

Send + 'staticи способы ее обходаtrait_variant- Явный future

- Нотация возвращаемого типа (Return Type Notation, RTN) (https://blog.rust-lang.org/inside-rust/2024/09/26/rtn-call-for-testing.html)

- Проблема с

- Переопределение (overriding)

- Нотация future против async для методов

- Безопасность объектов (object safety)

- Правила захвата (capture rules) (https://blog.rust-lang.org/2024/09/05/impl-trait-capture-rules.html)

- История и крейт

async-trait

Рекурсия (Recursion)

- Разрешена (относительно недавно), но требует явного помещения в

Box(boxing).- Ссылка вперед на фьючерсы, закрепление (pinning)

- https://rust-lang.github.io/async-book/07_workarounds/04_recursion.html

- https://blog.rust-lang.org/2024/03/21/Rust-1.77.0.html#support-for-recursion-in-async-fn

- Макрос

async-recursion(https://docs.rs/async-recursion/latest/async_recursion/)

Рекурсивные асинхронные функции создают тип конечного автомата, который содержит сам себя, что приводит к типу бесконечного размера. Компилятор выдаст ошибку: "recursion in an async fn requires boxing".

Для исправления этой проблемы можно использовать крейт async_recursion, который предоставляет атрибут #[async_recursion] для автоматического преобразования функции. Этот макрос изменяет функцию так, чтобы она возвращала запакованный (boxed) фьючерс.

#![allow(unused)] fn main() { use async_recursion::async_recursion; #[async_recursion] async fn fib(n: u32) -> u32 { match n { 0 | 1 => 1, _ => fib(n-1).await + fib(n-2).await } } }

Макрос также позволяет контролировать ограничения трейтов для возвращаемого фьючерса с помощью опций (?Send) и (Sync).

-

Интересно сравнить отмену в асинхронном программировании с отменой потоков. Отменить поток возможно (например, с помощью

pthread_cancelв C; в Rust нет прямого способа сделать это), но это почти всегда очень и очень плохая идея, поскольку отменяемый поток может завершиться где угодно. В отличие от этого, отмена асинхронной задачи может произойти только в точке await. Как следствие, отмена потока ОС без завершения всего процесса происходит очень редко, и вам, как программисту, обычно не нужно об этом беспокоиться. Однако в асинхронном Rust отмена — это то, что может произойти. Мы обсудим, как с этим бороться, по мере нашего продвижения. ↩

Ввод-вывод и проблемы с блокировками

Эффективная обработка ввода-вывода (IO) является одной из основных причин использования асинхронного программирования, и большинство асинхронных программ выполняют много операций IO. Корень проблемы с IO заключается в том, что он занимает на порядки больше времени, чем вычисления, поэтому простое ожидание завершения IO вместо выполнения другой работы невероятно неэффективно. В идеале, асинхронное программирование позволяет программе заниматься другой работой во время ожидания IO.

Эта глава представляет собой введение в IO в асинхронном контексте. Мы рассмотрим важное различие между блокирующим и неблокирующим IO, и почему блокирующий IO и асинхронное программирование несовместимы (по крайней мере, без некоторой доли размышлений и усилий). Мы рассмотрим, как использовать неблокирующий IO, затем посмотрим на некоторые проблемы, которые могут возникнуть с IO и асинхронным программированием. Мы также рассмотрим, как операционная система обрабатывает IO, и мельком взглянем на некоторые альтернативные методы IO, такие как io_uring.

Мы закончим рассмотрением других способов блокировки асинхронной задачи (что плохо) и того, как правильно смешивать асинхронное программирование с блокирующим IO или длительными, ресурсоёмкими вычислениями.

Блокирующий и неблокирующий IO

IO реализуется операционной системой; работа по IO происходит в отдельных процессах и/или на специализированном оборудовании, в любом случае вне процесса программы. IO может быть синхронным или асинхронным (также известным как блокирующий и неблокирующий, соответственно). Синхронный IO означает, что программа (или, по крайней мере, поток) ожидает (то есть блокируется) во время выполнения IO и не начинает обработку, пока IO не завершится и результат не будет получен от ОС. Асинхронный IO означает, что программа может продолжать выполнять работу во время выполнения IO и может забрать результат позже. Существует множество различных API ОС для обоих видов IO, хотя больше разнообразия в асинхронной сфере.

Асинхронный IO и асинхронное программирование не связаны по своей сути. Однако асинхронное программирование способствует эргономичному и производительному асинхронному IO, и это является основной мотивацией для асинхронного программирования. Блокировки из-за синхронного IO являются основным источником проблем с производительностью в асинхронном программировании, и мы должны быть осторожны, чтобы избежать их (подробнее об этом ниже).

Стандартная библиотека Rust включает функции и трейты для блокирующего IO. Для неблокирующего IO вы должны использовать специализированные библиотеки, которые часто являются частью асинхронной среды выполнения, например, модуль io в Tokio.

Давайте быстро взглянем на пример (адаптированный из документации Tokio):

#![allow(unused)] fn main() { use tokio::{io::AsyncWriteExt, net::TcpStream}; async fn write_hello() -> Result<(), Box<dyn std::error::Error>> { let mut stream = TcpStream::connect("127.0.0.1:8080").await?; stream.write_all(b"hello world!").await?; Ok(()) } }

write_all — это асинхронный метод IO, который записывает данные в stream. Это может завершиться сразу, но более вероятно, что это займёт некоторое время, поэтому stream.write_all(...).await приведёт к приостановке текущей задачи во время ожидания обработки записи ОС. Планировщик будет запускать другие задачи, и когда запись завершится, он разбудит задачу и запланирует её продолжение.

Однако, если бы мы использовали функцию записи из стандартной библиотеки, асинхронный планировщик не был бы задействован, и ОС приостановила бы весь поток на время завершения IO, что означает, что не только текущая задача приостанавливается, но и никакая другая задача не может быть выполнена с использованием этого потока. Если это произойдёт со всеми потоками в пуле потоков среды выполнения (который в некоторых обстоятельствах может состоять всего из одного потока), то вся программа останавливается и не может прогрессировать. Это называется блокировкой потока (или программы) и очень плохо сказывается на производительности. Важно никогда не блокировать потоки в асинхронной программе, и поэтому вам следует избегать использования блокирующего IO в асинхронной задаче.

Блокировка потока может быть вызвана длительными задачами или задачами, ожидающими блокировок, а также блокирующим IO. Мы обсудим это подробнее в конце этой главы.

Распространённым шаблоном является многократное чтение или запись, и потоки (streams) и приёмники (sinks) (также известные как асинхронные итераторы) являются удобным механизмом для этого. Они рассматриваются в отдельной главе.

Чтение и запись

TODO

- Асинхронные трейты Read и Write

- часть среды выполнения

- Как использовать

- Конкретные реализации

- Сеть против диска

- TCP, UDP

- Файловая система не совсем асинхронна, но io_uring (ссылка на эту главу)

- Практические примеры

- stdout и т.д.

- Каналы (pipe), файловые дескрипторы (fd) и т.д.

- Сеть против диска

Управление памятью

Когда мы читаем данные, нам нужно куда-то их поместить, а когда мы записываем данные, их нужно где-то хранить до завершения записи. В любом случае, то, как управляется эта память, важно.

TODO

- Проблемы с управлением буферами и асинхронным IO

- Различные решения и их плюсы и минусы

- Подход с нулевым копированием (zero-copy)

- Подход с общим буфером