Учебник Tokio

Учебное руководство

Tokio — это асинхронная среда выполнения (runtime) для языка программирования Rust. Она предоставляет строительные блоки, необходимые для написания сетевых приложений. Tokio дает гибкость для работы с широким спектром систем — от больших серверов с десятками ядер до небольших встраиваемых устройств.

На высоком уровне Tokio предоставляет несколько основных компонентов:

- Многопоточную среду выполнения для исполнения асинхронного кода

- Асинхронную версию стандартной библиотеки

- Большую экосистему библиотек

Роль Tokio в вашем проекте

Когда вы пишете приложение в асинхронном стиле, вы позволяете ему лучше масштабироваться за счет снижения стоимости одновременного выполнения множества операций. Однако асинхронный код Rust не работает сам по себе, поэтому вам необходимо выбрать среду выполнения. Библиотека Tokio является наиболее широко используемой средой выполнения, превосходящей по использованию все остальные среды вместе взятые.

Кроме того, Tokio предоставляет множество полезных утилит. При написании асинхронного кода вы не можете использовать обычные блокирующие API, предоставляемые стандартной библиотекой Rust, и вместо этого должны использовать их асинхронные версии. Эти альтернативные версии предоставляются Tokio и повторяют API стандартной библиотеки Rust там, где это имеет смысл.

Преимущества Tokio

В этом разделе описаны некоторые преимущества Tokio.

Быстродействие Tokio — быстрый, построенный на основе языка программирования Rust, который сам по себе быстрый. Это сделано в духе Rust с целью, чтобы вы не могли улучшить производительность, написав эквивалентный код вручную.

Tokio — масштабируемый, построенный на основе функциональности языка async/await, которая сама по себе масштабируема. При работе с сетевыми соединениями существует предел скорости обработки одного соединения из-за задержек, поэтому единственный способ масштабирования — одновременная обработка множества соединений. С функцией языка async/await увеличение количества concurrent-операций становится incredibly дешевым, позволяя масштабироваться до большого количества одновременных задач.

Надежность Tokio построен с использованием Rust — языка, который позволяет каждому создавать надежное и эффективное программное обеспечение. Ряд исследований показал, что примерно ~70% критических уязвимостей безопасности являются результатом небезопасной работы с памятью. Использование Rust устраняет весь этот класс ошибок в ваших приложениях.

Tokio также уделяет большое внимание обеспечению последовательного поведения без сюрпризов. Основная цель Tokio — позволить пользователям развертывать предсказуемое программное обеспечение, которое будет работать одинаково изо дня в день с надежным временем отклика и без непредсказуемых скачков задержки.

Простота С функцией async/await в Rust сложность написания асинхронных приложений существенно снизилась. В сочетании с утилитами Tokio и vibrant экосистемой написание приложений становится легким.

Tokio следует соглашениям об именовании стандартной библиотеки, где это имеет смысл. Это позволяет легко преобразовывать код, написанный только со стандартной библиотекой, в код, написанный с Tokio. С сильной системой типов Rust возможность легко создавать корректный код не имеет аналогов.

Гибкость Tokio предоставляет несколько вариантов среды выполнения — от многопоточной среды с work-stealing до легковесной однопоточной среды. Каждая из этих сред выполнения поставляется с множеством настроек, позволяющих пользователям адаптировать их к своим потребностям.

Когда не следует использовать Tokio

Хотя Tokio полезен для многих проектов, которым необходимо выполнять множество операций одновременно, есть также случаи, когда Tokio не подходит.

- Ускорение вычислений, ограниченных производительностью CPU, путем их параллельного выполнения в нескольких потоках. Tokio разработан для приложений, ограниченных производительностью I/O, где каждая отдельная задача тратит большую часть времени на ожидание I/O. Если ваше приложение только выполняет параллельные вычисления, вам следует использовать rayon. Тем не менее, все еще возможно "смешивать и сочетать", если вам нужно делать и то, и другое.

- Чтение большого количества файлов. Хотя может показаться, что Tokio будет полезен для проектов, которым просто нужно читать много файлов, Tokio не дает здесь преимуществ по сравнению с обычным пулом потоков. Это связано с тем, что операционные системы обычно не предоставляют асинхронные API для работы с файлами.

- Отправка одного веб-запроса. Tokio дает преимущество, когда вам нужно делать много вещей одновременно. Если вам нужно использовать библиотеку, предназначенную для асинхронного Rust, такую как reqwest, но вам не нужно делать много операций одновременно, вам следует предпочесть блокирующую версию этой библиотеки, так как это упростит ваш проект. Использование Tokio, конечно, все равно будет работать, но не даст реальных преимуществ по сравнению с блокирующим API.

Получение помощи

В любой момент, если вы застряли, вы всегда можете получить помощь в Discord или обсуждениях на GitHub. Не беспокойтесь о задавании "начальных" вопросов. Мы все с чего-то начинали и рады помочь.

Определения

Асинхронность

В контексте Rust асинхронный код относится к коду, который использует функцию языка async/await, позволяющую многим задачам работать конкурентно на нескольких потоках (или даже одном потоке).

Конкурентность и параллелизм

Конкурентность и параллелизм — это два связанных понятия, которые используются при обсуждении выполнения нескольких задач одновременно. Если что-то происходит параллельно, то это также происходит конкурентно, но обратное неверно: переключение между двумя задачами без фактической одновременной работы над ними — это конкурентность, но не параллелизм.

Future (Футура/Будущее)

Future — это значение, которое хранит текущее состояние некоторой операции. Future также имеет метод poll, который позволяет операции продолжаться до тех пор, пока ей не потребуется ожидать чего-либо, например, сетевого соединения. Вызовы метода poll должны возвращаться очень быстро.

Future часто создаются путем комбинирования нескольких future с использованием .await в async-блоке.

Исполнитель/Планировщик

Исполнитель или планировщик — это нечто, что выполняет future, многократно вызывая метод poll. В стандартной библиотеке нет исполнителя, поэтому для этого нужна внешняя библиотека, и наиболее широко используемый исполнитель предоставляется средой выполнения Tokio.

Исполнитель способен запускать большое количество future конкурентно на нескольких потоках. Он делает это, переключая текущую задачу в точках await. Если код проводит много времени без достижения .await, это называется "блокировкой потока" или "не возвращением управления исполнителю", что мешает запуску других задач.

Среда выполнения

Среда выполнения — это библиотека, которая содержит исполнитель вместе с различными утилитами, интегрированными с этим исполнителем, такими как утилиты времени и ввода-вывода. Слова "среда выполнения" и "исполнитель" иногда используются взаимозаменяемо. В стандартной библиотеке нет среды выполнения, поэтому для этого нужна внешняя библиотека, и наиболее широко используемой средой выполнения является среда выполнения Tokio.

Слово "Runtime" также используется в других контекстах, например, фраза "У Rust нет runtime" иногда означает, что Rust не выполняет сборку мусора или JIT-компиляцию.

Задача

Задача — это операция, выполняемая в среде выполнения Tokio, создаваемая функцией tokio::spawn или Runtime::block_on. Инструменты для создания future путем их комбинирования, такие как .await и join!, не создают новых задач, и каждая комбинируемая часть считается "в той же задаче".

Для параллелизма требуется несколько задач, но возможно конкурентно выполнять несколько операций в одной задаче с помощью таких инструментов, как join!.

Порождающее создание

Порождающее создание — это когда функция tokio::spawn используется для создания новой задачи. Это также может относиться к созданию нового потока с помощью std::thread::spawn.

Async-блок

Async-блок — это простой способ создать future, который выполняет некоторый код. Например:

#![allow(unused)] fn main() { let world = async { println!(" world!"); }; let my_future = async { print!("Hello "); world.await; }; }

Код выше создает future с именем my_future, который при выполнении печатает Hello world!. Он делает это, сначала печатая "Hello", а затем выполняя future world. Обратите внимание, что сам по себе этот код ничего не печатает — вам нужно фактически выполнить my_future, либо напрямую создав его как задачу, либо используя .await в чем-то, что вы создаете.

Async-функция

Подобно async-блоку, async-функция — это простой способ создать функцию, тело которой становится future. Все async-функции можно переписать в обычные функции, возвращающие future:

#![allow(unused)] fn main() { async fn do_stuff(i: i32) -> String { // do stuff format!("The integer is {}.", i) } }

#![allow(unused)] fn main() { use std::future::Future; // async-функция выше аналогична этой: fn do_stuff(i: i32) -> impl Future<Output = String> { async move { // do stuff format!("The integer is {}.", i) } } }

Здесь используется синтаксис impl Trait для возврата future, поскольку Future — это трейт. Обратите внимание, что поскольку future, созданный async-блоком, ничего не делает до своего выполнения, вызов async-функции ничего не делает до тех пор, пока не будет выполнен возвращаемый future (игнорирование этого вызывает предупреждение).

Уступка управления

В контексте асинхронного Rust уступка управления — это то, что позволяет исполнителю выполнять множество future в одном потоке. Каждый раз, когда future уступает управление, исполнитель может заменить этот future другим future, и, многократно переключая текущую задачу, исполнитель может конкурентно выполнять большое количество задач. Future может уступить управление только в .await, поэтому future, которые проводят много времени между .await, могут препятствовать выполнению других задач.

Если конкретно, future уступает управление, когда возвращается из метода poll.

Блокировка

Слово "блокировка" используется двумя разными способами: первое значение "блокировки" — это просто ожидание завершения чего-либо, а другое значение блокировки — когда future проводит много времени без уступки управления. Для однозначности можно использовать фразу "блокировка потока" для второго значения.

Документация Tokio всегда будет использовать второе значение "блокировки".

Для выполнения блокирующего кода в Tokio см. раздел Задачи, ограниченные CPU, и блокирующий код в справочнике по API Tokio.

Поток

Stream — это асинхронная версия Iterator, предоставляющая поток значений. Он обычно используется вместе с циклом while let, например:

#![allow(unused)] fn main() { use tokio_stream::StreamExt; // для next() async fn dox() { let mut stream = tokio_stream::empty::<()>(); while let Some(item) = stream.next().await { // что-то делаем } } }

Слово "поток" иногда по ошибке используется для обозначения трейтов AsyncRead и AsyncWrite.

Утилиты для потоков Tokio в настоящее время предоставляются крейтом tokio-stream. Когда трейт Stream стабилизируется в std, утилиты потоков будут перемещены в крейт tokio.

Канал

Канал — это инструмент, который позволяет одной части кода отправлять сообщения другим частям. Tokio предоставляет несколько каналов, каждый из которых служит своей цели.

- mpsc: многопоточный отправитель, однопоточный получатель. Можно отправить много значений.

- oneshot: однопоточный отправитель, однопоточный получатель. Можно отправить одно значение.

- broadcast: многопоточный отправитель, многопоточный получатель. Можно отправить много значений. Каждый получатель видит каждое значение.

- watch: однопоточный отправитель, многопоточный получатель. Можно отправить много значений, но история не сохраняется. Получатели видят только последнее значение.

Если вам нужен многопоточный отправитель/многопоточный получатель канала, где только один получатель видит каждое сообщение, вы можете использовать крейт async-channel.

Также существуют каналы для использования вне асинхронного Rust, такие как std::sync::mpsc и crossbeam::channel. Эти каналы ожидают сообщения, блокируя поток, что не допускается в асинхронном коде.

Обратное давление

Обратное давление — это шаблон проектирования приложений, которые хорошо справляются с высокой нагрузкой. Например, канал mpsc бывает как ограниченным, так и неограниченным. Используя ограниченный канал, получатель может создавать "обратное давление" на отправителя, если получатель не успевает обрабатывать количество сообщений, что позволяет избежать неограниченного роста использования памяти при отправке все большего количества сообщений по каналу.

Актор

Шаблон проектирования для создания приложений. Актор — это независимо созданная задача, которая управляет некоторым ресурсом от имени других частей приложения, используя каналы для связи с этими другими частями приложения.

См. главу о каналах для примера актора.

Установка

Это руководство шаг за шагом проведет вас через процесс создания Redis клиента и сервера. Мы начнем с основ асинхронного программирования на Rust и будем постепенно углубляться. Мы реализуем подмножество команд Redis, но получим комплексный обзор Tokio.

Mini-Redis

Проект, который вы будете создавать в этом руководстве, доступен как Mini-Redis на GitHub. Mini-Redis разработан с основной целью изучения Tokio и поэтому хорошо прокомментирован, но это также означает, что Mini-Redis отсутствуют некоторые функции, которые вы хотели бы видеть в реальной Redis-библиотеке. Вы можете найти готовые к использованию в production Redis-библиотеки на crates.io.

Мы будем напрямую использовать Mini-Redis в этом руководстве. Это позволяет нам использовать части Mini-Redis в руководстве до того, как мы реализуем их позже.

Получение помощи

В любой момент, если вы застряли, вы всегда можете получить помощь в Discord или обсуждениях на GitHub. Не беспокойтесь о задавании "начальных" вопросов. Мы все с чего-то начинали и рады помочь.

Предварительные требования

Читатели должны уже быть знакомы с Rust. Книга по Rust — отличный ресурс для начала.

Хотя это и не обязательно, некоторый опыт написания сетевого кода с использованием стандартной библиотеки Rust или другого языка может быть полезен.

Знание Redis не требуется.

Rust

Прежде чем начать, убедитесь, что у вас установлен и готов к работе набор инструментов Rust. Если у вас его нет, самый простой способ установить — использовать rustup.

Это руководство требует минимальной версии Rust 1.45.0, но рекомендуется использовать последнюю стабильную версию Rust.

Чтобы проверить, установлен ли Rust на вашем компьютере, выполните:

$ rustc --version

Вы должны увидеть вывод примерно такой: rustc 1.46.0 (04488afe3 2020-08-24).

Сервер Mini-Redis

Далее установите сервер Mini-Redis. Он будет использоваться для тестирования нашего клиента по мере его создания.

$ cargo install mini-redis

Убедитесь, что установка прошла успешно, запустив сервер:

$ mini-redis-server

Затем в отдельном окне терминала попробуйте получить ключ foo с помощью mini-redis-cli:

$ mini-redis-cli get foo

Вы должны увидеть (nil).

Все готово

Вот и все, все готово к работе. Перейдите на следующую страницу, чтобы написать свое первое асинхронное приложение на Rust.

hello tokio

Мы начнем с написания очень простого приложения на Tokio. Оно подключится к серверу Mini-Redis, установит значение ключа hello в world, а затем прочитает этот ключ обратно. Это будет сделано с использованием клиентской библиотеки Mini-Redis.

Код

Генерация нового крейта

Давайте начнем с создания нового Rust-приложения:

$ cargo new my-redis

$ cd my-redis

Добавление зависимостей

Затем откройте Cargo.toml и добавьте следующее прямо под [dependencies]:

tokio = { version = "1", features = ["full"] }

mini-redis = "0.4"

Написание кода

Затем откройте main.rs и замените содержимое файла на:

use mini_redis::{client, Result}; fn dox() { #[tokio::main] async fn main() -> Result<()> { // Открываем соединение с адресом mini-redis. let mut client = client::connect("127.0.0.1:6379").await?; // Устанавливаем ключ "hello" со значением "world" client.set("hello", "world".into()).await?; // Получаем ключ "hello" let result = client.get("hello").await?; println!("got value from the server; result={:?}", result); Ok(()) } }

Убедитесь, что сервер Mini-Redis запущен. В отдельном окне терминала выполните:

$ mini-redis-server

Если вы еще не установили mini-redis, вы можете сделать это с помощью:

$ cargo install mini-redis

Теперь запустите приложение my-redis:

$ cargo run

got value from the server; result=Some(b"world")

Успех!

Полный код можно найти здесь.

Разбор кода

Давайте подробнее разберем, что мы только что сделали. Кода немного, но происходит много всего.

#![allow(unused)] fn main() { use mini_redis::client; async fn dox() -> mini_redis::Result<()> { let mut client = client::connect("127.0.0.1:6379").await?; Ok(()) } }

Функция client::connect предоставляется крейтом mini-redis. Она асинхронно устанавливает TCP-соединение с указанным удаленным адресом. После установления соединения возвращается handle client. Хотя операция выполняется асинхронно, код, который мы пишем, выглядит синхронным. Единственное указание на то, что операция асинхронная — это оператор .await.

Что такое асинхронное программирование?

Большинство компьютерных программ выполняются в том же порядке, в котором они написаны. Сначала выполняется первая строка, затем следующая и так далее. При синхронном программировании, когда программа встречает операцию, которая не может быть завершена немедленно, она блокируется до завершения операции. Например, установление TCP-соединения требует обмена с узлом по сети, что может занять значительное время. В течение этого времени поток заблокирован.

При асинхронном программировании операции, которые не могут быть завершены немедленно, приостанавливаются и переносятся в фон. Поток не блокируется и может продолжать выполнять другие задачи. Как только операция завершается, задача возобновляется и продолжает обработку с того места, где она остановилась. В нашем предыдущем примере была только одна задача, поэтому ничего не происходит, пока она приостановлена, но асинхронные программы обычно имеют много таких задач.

Хотя асинхронное программирование может привести к более быстрым приложениям, оно часто приводит к гораздо более сложным программам. Программист должен отслеживать все состояние, необходимое для возобновления работы после завершения асинхронной операции. Исторически это была утомительная и подверженная ошибкам задача.

Зеленые потоки во время компиляции

Rust реализует асинхронное программирование с помощью функции под названием async/await. Функции, которые выполняют асинхронные операции, помечаются ключевым словом async. В нашем примере функция connect определена так:

#![allow(unused)] fn main() { use mini_redis::Result; use mini_redis::client::Client; use tokio::net::ToSocketAddrs; pub async fn connect<T: ToSocketAddrs>(addr: T) -> Result<Client> { // ... unimplemented!() } }

Определение async fn выглядит как обычная синхронная функция, но работает асинхронно. Rust преобразует async fn во время компиляции в процедуру, которая работает асинхронно. Любые вызовы .await внутри async fn возвращают управление обратно потоку. Поток может выполнять другую работу, пока операция обрабатывается в фоне.

предупреждение Хотя другие языки также реализуют

async/await, Rust использует уникальный подход. В первую очередь, асинхронные операции Rust ленивы. Это приводит к другой семантике выполнения по сравнению с другими языками.

Если это пока не совсем понятно, не волнуйтесь. Мы подробнее исследуем async/await в этом руководстве.

Использование async/await

Асинхронные функции вызываются как любые другие функции Rust. Однако вызов этих функций не приводит к выполнению тела функции. Вместо этого вызов async fn возвращает значение, представляющее операцию. Это концептуально аналогично замыканию без аргументов. Чтобы фактически выполнить операцию, вы должны использовать оператор .await для возвращаемого значения.

Например, данная программа

async fn say_world() { println!("world"); } #[tokio::main] async fn main() { // Вызов `say_world()` не выполняет тело `say_world()`. let op = say_world(); // Этот println! выводится первым println!("hello"); // Вызов `.await` на `op` начинает выполнение `say_world`. op.await; }

выводит:

hello

world

Возвращаемое значение async fn — это анонимный тип, реализующий трейт Future.

Асинхронная функция main

Главная функция, используемая для запуска приложения, отличается от обычной, встречающейся в большинстве крейтов Rust.

- Это

async fn - Она аннотирована с

#[tokio::main]

async fn используется, потому что мы хотим войти в асинхронный контекст. Однако асинхронные функции должны выполняться средой выполнения (runtime). Среда выполнения содержит планировщик асинхронных задач, предоставляет событийный I/O, таймеры и т.д. Среда выполнения не запускается автоматически, поэтому главная функция должна её запустить.

Функция #[tokio::main] — это макрос. Она преобразует async fn main() в синхронную fn main(), которая инициализирует экземпляр среды выполнения и выполняет асинхронную главную функцию.

Например, следующий код:

#[tokio::main] async fn main() { println!("hello"); }

преобразуется в:

fn main() { let mut rt = tokio::runtime::Runtime::new().unwrap(); rt.block_on(async { println!("hello"); }) }

Подробности среды выполнения Tokio будут рассмотрены позже.

Cargo features

При подключении Tokio для этого руководства был включен флаг функции full:

tokio = { version = "1", features = ["full"] }

Tokio имеет много функциональности (TCP, UDP, Unix-сокеты, таймеры, утилиты синхронизации, несколько типов планировщиков и т.д.). Не всем приложениям нужна вся функциональность. При попытке оптимизировать время компиляции или размер конечного приложения, приложение может выбрать только те функции, которые оно использует.

Spawning

Мы переключимся и начнем работать над сервером Redis.

Сначала переместим клиентский код SET/GET из предыдущего раздела в примерный файл. Таким образом, мы сможем запускать его против нашего сервера.

$ mkdir -p examples

$ mv src/main.rs examples/hello-redis.rs

Затем создайте новый, пустой src/main.rs и продолжайте.

Принятие сокетов

Первое, что должен сделать наш сервер Redis — это принимать входящие TCP-сокеты. Это делается путем привязки tokio::net::TcpListener к порту 6379.

информация Многие типы Tokio называются так же, как их синхронные эквиваленты в стандартной библиотеке Rust. Когда это имеет смысл, Tokio предоставляет те же API, что и

std, но используяasync fn.

Затем сокеты принимаются в цикле. Каждый сокет обрабатывается, затем закрывается. Пока мы будем читать команду, выводить ее в stdout и отвечать ошибкой.

src/main.rs

use tokio::net::{TcpListener, TcpStream}; use mini_redis::{Connection, Frame}; fn dox() { #[tokio::main] async fn main() { // Привязываем слушателя к адресу let listener = TcpListener::bind("127.0.0.1:6379").await.unwrap(); loop { // Второй элемент содержит IP и порт нового соединения. let (socket, _) = listener.accept().await.unwrap(); process(socket).await; } } } async fn process(socket: TcpStream) { // `Connection` позволяет нам читать/писать **фреймы** redis вместо потоков байтов. // Тип `Connection` определен в mini-redis. let mut connection = Connection::new(socket); if let Some(frame) = connection.read_frame().await.unwrap() { println!("GOT: {:?}", frame); // Отвечаем ошибкой let response = Frame::Error("unimplemented".to_string()); connection.write_frame(&response).await.unwrap(); } }

Теперь запустите этот цикл принятия:

$ cargo run

В отдельном окне терминала запустите пример hello-redis (команда SET/GET из предыдущего раздела, которая играет роль клиента Redis):

$ cargo run --example hello-redis

Вывод должен быть:

Error: "unimplemented"

В терминале сервера вывод:

GOT: Array([Bulk(b"set"), Bulk(b"hello"), Bulk(b"world")])

Конкурентность

У нашего сервера есть небольшая проблема (кроме того, что он отвечает только ошибками). Он обрабатывает входящие запросы по одному. Когда соединение принято, сервер остается внутри блокировки цикла принятия до тех пор, пока ответ полностью не записан в сокет.

Мы хотим, чтобы наш сервер Redis обрабатывал много конкурентных запросов. Для этого нам нужно добавить немного конкурентности.

информация Конкурентность и параллелизм — не одно и то же. Если вы переключаетесь между двумя задачами, то вы работаете над обеими задачами конкурентно, но не параллельно. Чтобы это считалось параллельным, вам нужно два человека, каждый из которых посвящен своей задаче.

Одно из преимуществ использования Tokio заключается в том, что асинхронный код позволяет вам работать над многими задачами конкурентно, без необходимости работать над ними параллельно с использованием обычных потоков. Фактически, Tokio может запускать многие задачи конкурентно в одном потоке!

Чтобы обрабатывать соединения конкурентно, для каждого входящего соединения создается новая задача. Соединение обрабатывается в этой задаче.

Цикл принятия становится:

use tokio::net::TcpListener; fn dox() { #[tokio::main] async fn main() { let listener = TcpListener::bind("127.0.0.1:6379").await.unwrap(); loop { let (socket, _) = listener.accept().await.unwrap(); // Для каждого входящего сокета создается новая задача. Сокет перемещается в новую задачу и обрабатывается там. tokio::spawn(async move { process(socket).await; }); } } } async fn process(_: tokio::net::TcpStream) {}

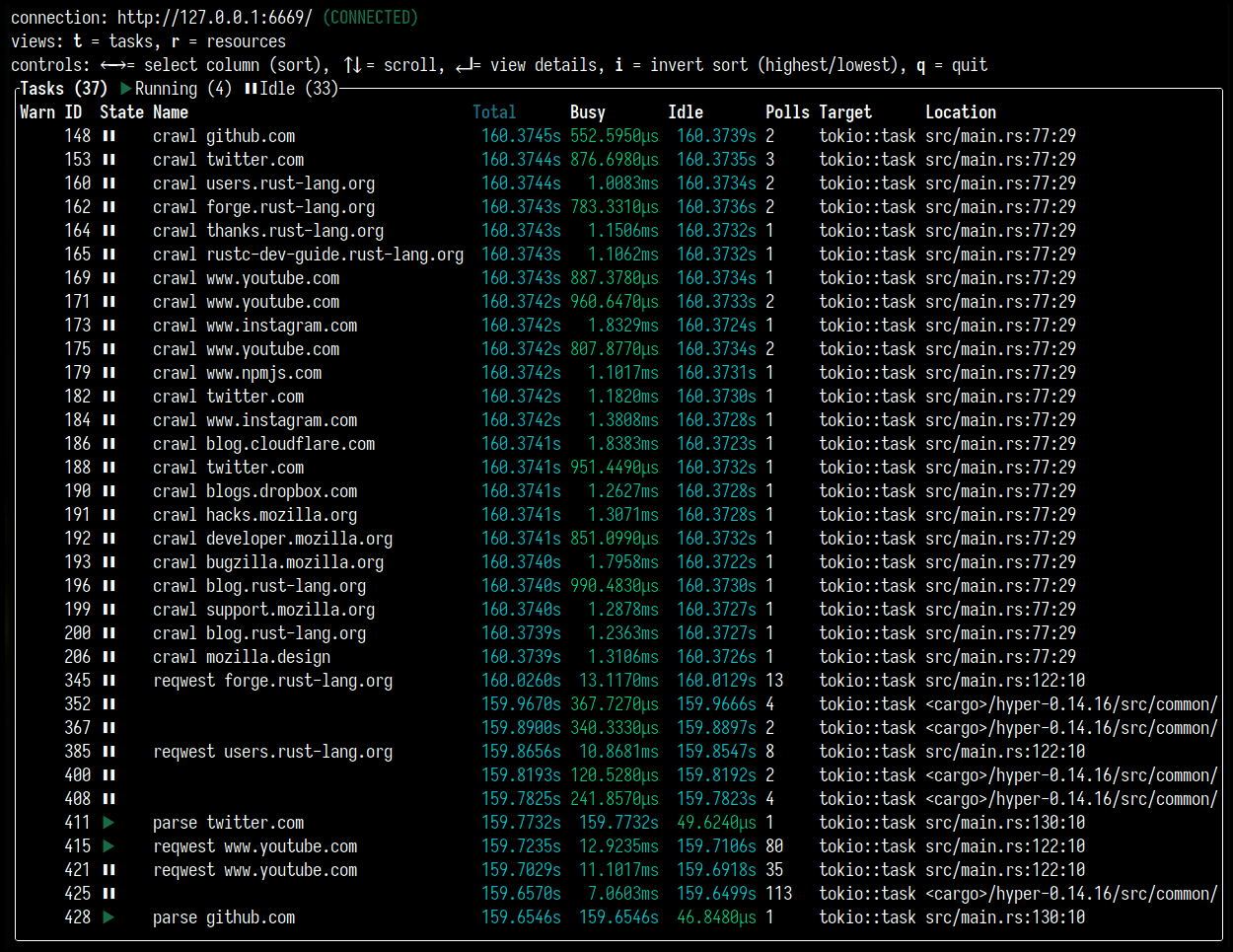

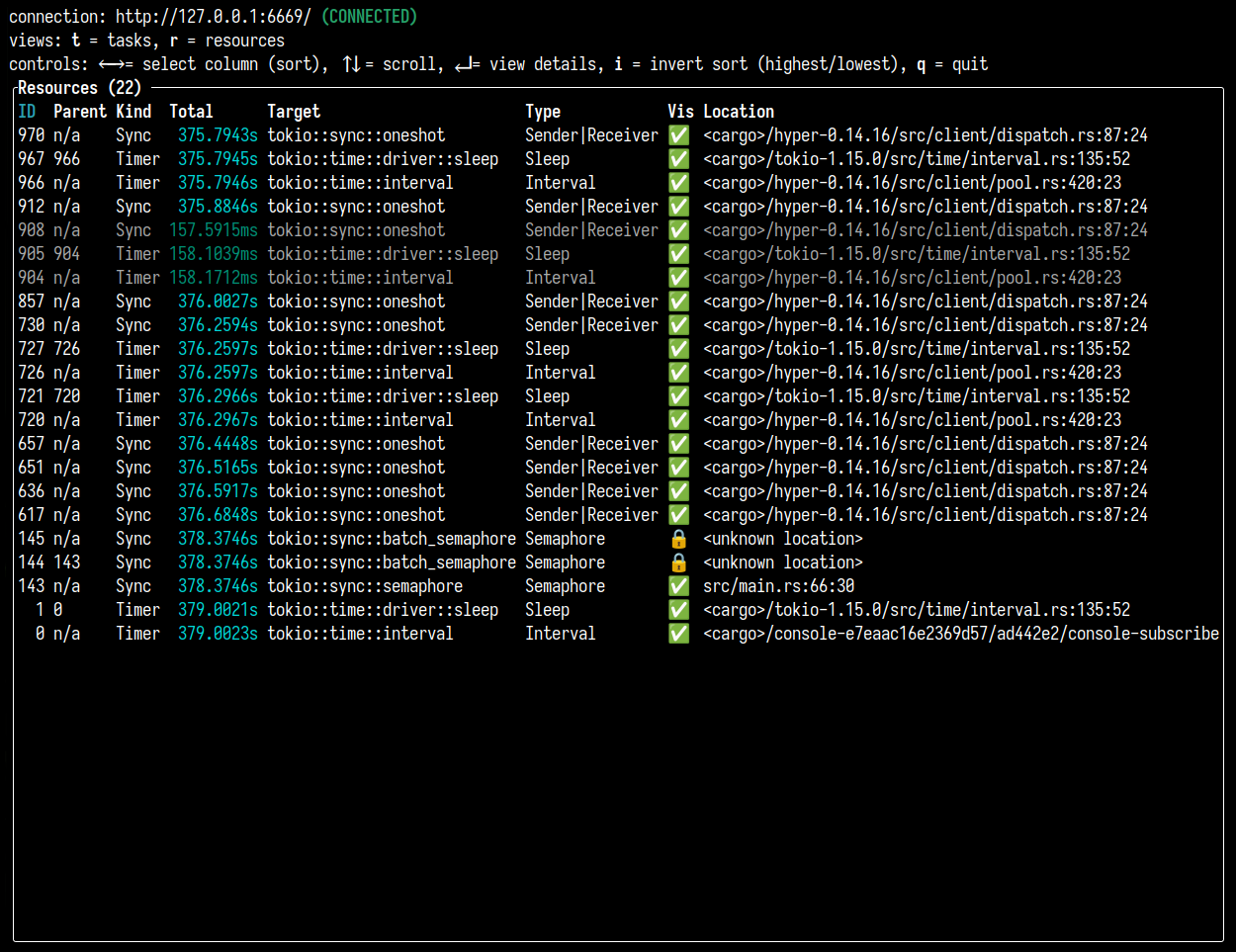

Задачи

Задача Tokio — это асинхронный зеленый поток. Они создаются путем передачи async блока в tokio::spawn. Функция tokio::spawn возвращает JoinHandle, который вызывающая сторона может использовать для взаимодействия с созданной задачей. async блок может иметь возвращаемое значение. Вызывающая сторона может получить возвращаемое значение с помощью .await на JoinHandle.

Например:

#[tokio::main] async fn main() { let handle = tokio::spawn(async { // Выполняем некоторую асинхронную работу "return value" }); // Выполняем другую работу let out = handle.await.unwrap(); println!("GOT {}", out); }

Ожидание JoinHandle возвращает Result. Когда задача встречает ошибку во время выполнения, JoinHandle вернет Err. Это происходит, когда задача либо паникует, либо когда задача принудительно отменяется из-за остановки среды выполнения.

Задачи — это единица выполнения, управляемая планировщиком. Создание задачи отправляет ее в планировщик Tokio, который затем обеспечивает выполнение задачи, когда у нее есть работа. Созданная задача может выполняться в том же потоке, где она была создана, или может выполняться в другом потоке среды выполнения. Задача также может быть перемещена между потоками после создания.

Задачи в Tokio очень легковесны. Под капотом они требуют только одно выделение памяти и 64 байта памяти. Приложения должны свободно создавать тысячи, если не миллионы задач.

Ограничение 'static

Когда вы создаете задачу в среде выполнения Tokio, время жизни ее типа должно быть 'static. Это означает, что созданная задача не должна содержать ссылок на данные, владеемые вне задачи.

информация Распространенное заблуждение, что

'staticвсегда означает "живет вечно", но это не так. Только потому, что значение'static, не означает, что у вас утечка памяти. Вы можете прочитать больше в Common Rust Lifetime Misconceptions.

Например, следующий код не скомпилируется:

use tokio::task; #[tokio::main] async fn main() { let v = vec![1, 2, 3]; task::spawn(async { println!("Here's a vec: {:?}", v); }); }

Попытка компиляции приводит к следующей ошибке:

error[E0373]: async block may outlive the current function, but

it borrows `v`, which is owned by the current function

--> src/main.rs:7:23

|

7 | task::spawn(async {

| _______________________^

8 | | println!("Here's a vec: {:?}", v);

| | - `v` is borrowed here

9 | | });

| |_____^ may outlive borrowed value `v`

|

note: function requires argument type to outlive `'static`

--> src/main.rs:7:17

|

7 | task::spawn(async {

| _________________^

8 | | println!("Here's a vector: {:?}", v);

9 | | });

| |_____^

help: to force the async block to take ownership of `v` (and any other

referenced variables), use the `move` keyword

|

7 | task::spawn(async move {

8 | println!("Here's a vec: {:?}", v);

9 | });

|

Это происходит потому, что по умолчанию переменные не перемещаются в async блоки. Вектор v остается во владении функции main. Строка println! заимствует v. Компилятор Rust любезно объясняет это нам и даже предлагает исправление! Изменение строки 7 на task::spawn(async move { предпишет компилятору переместить v в созданную задачу. Теперь задача владеет всеми своими данными, делая их 'static.

Если к одним данным должен быть доступ из более чем одной задачи конкурентно, то они должны быть общими с использованием примитивов синхронизации, таких как Arc.

Обратите внимание, что сообщение об ошибке говорит о том, что тип аргумента переживает время жизни 'static. Эта терминология может быть довольно запутанной, потому что время жизни 'static длится до конца программы, так что если он переживает его, разве это не утечка памяти? Объяснение в том, что это тип, а не значение должен переживать время жизни 'static, и значение может быть уничтожено до того, как его тип станет недействительным.

Когда мы говорим, что значение 'static, все это означает, что не будет ошибкой хранить это значение вечно. Это важно, потому что компилятор не может рассуждать о том, как долго новая задача остается активной. Мы должны убедиться, что задаче разрешено жить вечно, чтобы Tokio мог заставить задачу работать так долго, как это необходимо.

Статья, на которую ссылается предыдущий информационный блок, использует терминологию "ограничено 'static" вместо "его тип переживает 'static" или "значение 'static" для ссылки на T: 'static. Все это означает одно и то же, но отличается от "аннотировано с 'static" как в &'static T.

Ограничение Send

Задачи, созданные с помощью tokio::spawn, должны реализовывать Send. Это позволяет среде выполнения Tokio перемещать задачи между потоками, пока они приостановлены на .await.

Задачи являются Send, когда все данные, которые хранятся между вызовами .await, являются Send. Это немного тонко. Когда вызывается .await, задача возвращается к планировщику. В следующий раз, когда задача выполняется, она возобновляется с точки, где она последний раз уступила. Чтобы это работало, все состояние, которое используется после .await, должно быть сохранено задачей. Если это состояние Send, т.е. может быть перемещено между потоками, то сама задача может быть перемещена между потоками. И наоборот, если состояние не Send, то и задача тоже.

Например, это работает:

use tokio::task::yield_now; use std::rc::Rc; #[tokio::main] async fn main() { tokio::spawn(async { // Область видимости заставляет `rc` удалиться до `.await`. { let rc = Rc::new("hello"); println!("{}", rc); } // `rc` больше не используется. Он **не** сохраняется, когда задача уступает планировщику yield_now().await; }); }

А это нет:

use tokio::task::yield_now; use std::rc::Rc; #[tokio::main] async fn main() { tokio::spawn(async { let rc = Rc::new("hello"); // `rc` используется после `.await`. Он должен быть сохранен в состоянии задачи. yield_now().await; println!("{}", rc); }); }

Попытка компиляции фрагмента приводит к:

error: future cannot be sent between threads safely

--> src/main.rs:6:5

|

6 | tokio::spawn(async {

| ^^^^^^^^^^^^ future created by async block is not `Send`

|

::: [..]spawn.rs:127:21

|

127 | T: Future + Send + 'static,

| ---- required by this bound in

| `tokio::task::spawn::spawn`

|

= help: within `impl std::future::Future`, the trait

| `std::marker::Send` is not implemented for

| `std::rc::Rc<&str>`

note: future is not `Send` as this value is used across an await

--> src/main.rs:10:9

|

7 | let rc = Rc::new("hello");

| -- has type `std::rc::Rc<&str>` which is not `Send`

...

10 | yield_now().await;

| ^^^^^^^^^^^^^^^^^ await occurs here, with `rc` maybe

| used later

11 | println!("{}", rc);

12 | });

| - `rc` is later dropped here

Мы обсудим особый случай этой ошибки более подробно в следующей главе.

Хранение значений

Теперь мы реализуем функцию process для обработки входящих команд. Мы будем использовать HashMap для хранения значений. Команды SET будут вставлять в HashMap, а команды GET будут загружать их. Дополнительно мы будем использовать цикл для принятия более одной команды на соединение.

#![allow(unused)] fn main() { use tokio::net::TcpStream; use mini_redis::{Connection, Frame}; async fn process(socket: TcpStream) { use mini_redis::Command::{self, Get, Set}; use std::collections::HashMap; // Для хранения данных используется хэш-карта let mut db = HashMap::new(); // Connection, предоставляемый `mini-redis`, обрабатывает разбор фреймов из сокета let mut connection = Connection::new(socket); // Используем `read_frame` для получения команды из соединения. while let Some(frame) = connection.read_frame().await.unwrap() { let response = match Command::from_frame(frame).unwrap() { Set(cmd) => { // Значение хранится как `Vec<u8>` db.insert(cmd.key().to_string(), cmd.value().to_vec()); Frame::Simple("OK".to_string()) } Get(cmd) => { if let Some(value) = db.get(cmd.key()) { // `Frame::Bulk` ожидает данные типа `Bytes`. Этот тип будет рассмотрен позже в руководстве. Пока `&Vec<u8>` преобразуется в `Bytes` с помощью `into()`. Frame::Bulk(value.clone().into()) } else { Frame::Null } } cmd => panic!("unimplemented {:?}", cmd), }; // Записываем ответ клиенту connection.write_frame(&response).await.unwrap(); } } }

Теперь запустите сервер:

$ cargo run

и в отдельном окне терминала снова запустите пример клиента hello-redis:

$ cargo run --example hello-redis

Теперь вывод клиента будет:

got value from the server; result=Some(b"world")

Теперь мы можем получать и устанавливать значения, но есть проблема: значения не являются общими между соединениями. Если другой сокет подключится и попытается GET ключ hello, он ничего не найдет.

Полный код можно найти здесь.

В следующем разделе мы реализуем сохранение данных для всех сокетов.

Shared state

До сих пор у нас работал ключ-значение сервер. Однако есть серьезный недостаток: состояние не является общим между соединениями. Мы исправим это в этой статье.

Стратегии

Есть несколько различных способов разделения состояния в Tokio.

- Защита общего состояния с помощью Mutex.

- Создание задачи для управления состоянием и использование передачи сообщений для работы с ним.

Обычно вы хотите использовать первый подход для простых данных и второй подход для вещей, которые требуют асинхронной работы, таких как примитивы I/O. В этой главе общее состояние - это HashMap, а операции - insert и get. Ни одна из этих операций не является асинхронной, поэтому мы будем использовать Mutex.

Второй подход рассматривается в следующей главе.

Добавление зависимости bytes

Вместо использования Vec<u8>, крейт Mini-Redis использует Bytes из крейта bytes. Цель Bytes - предоставить надежную структуру байтового массива для сетевого программирования. Самая большая особенность, которую он добавляет по сравнению с Vec<u8>, - это поверхностное клонирование. Другими словами, вызов clone() на экземпляре Bytes не копирует базовые данные. Вместо этого экземпляр Bytes является ссылочно-считаемым handle к некоторым базовым данным. Тип Bytes примерно похож на Arc<Vec<u8>>, но с некоторыми дополнительными возможностями.

Чтобы добавить зависимость bytes, добавьте следующее в ваш Cargo.toml в раздел [dependencies]:

bytes = "1"

Инициализация HashMap

HashMap будет общим для многих задач и потенциально многих потоков. Для поддержки этого он обернут в Arc<Mutex<_>>.

Сначала для удобства добавьте следующий псевдоним типа после операторов use.

#![allow(unused)] fn main() { use bytes::Bytes; use std::collections::HashMap; use std::sync::{Arc, Mutex}; type Db = Arc<Mutex<HashMap<String, Bytes>>>; }

Затем обновите функцию main для инициализации HashMap и передачи handle Arc в функцию process. Использование Arc позволяет на HashMap ссылаться конкурентно из многих задач, потенциально выполняющихся на многих потоках. В Tokio термин handle используется для ссылки на значение, которое предоставляет доступ к некоторому общему состоянию.

use tokio::net::TcpListener; use std::collections::HashMap; use std::sync::{Arc, Mutex}; fn dox() { #[tokio::main] async fn main() { let listener = TcpListener::bind("127.0.0.1:6379").await.unwrap(); println!("Listening"); let db = Arc::new(Mutex::new(HashMap::new())); loop { let (socket, _) = listener.accept().await.unwrap(); // Клонируем handle к хэш-карте. let db = db.clone(); println!("Accepted"); tokio::spawn(async move { process(socket, db).await; }); } } } type Db = Arc<Mutex<HashMap<(), ()>>>; async fn process(_: tokio::net::TcpStream, _: Db) {}

О использовании std::sync::Mutex и tokio::sync::Mutex

Обратите внимание, что std::sync::Mutex и не tokio::sync::Mutex используется для защиты HashMap. Распространенная ошибка - безусловно использовать tokio::sync::Mutex в асинхронном коде. Асинхронный мьютекс - это мьютекс, который блокируется при вызовах .await.

Синхронный мьютекс будет блокировать текущий поток при ожидании получения блокировки. Это, в свою очередь, заблокирует обработку других задач. Однако переключение на tokio::sync::Mutex обычно не помогает, поскольку асинхронный мьютекс использует синхронный мьютекс внутри.

Как правило, использование синхронного мьютекса в асинхронном коде допустимо, пока конкуренция остается низкой и блокировка не удерживается при вызовах .await.

Обновление process()

Функция process больше не инициализирует HashMap. Вместо этого она принимает общий handle к HashMap в качестве аргумента. Также необходимо заблокировать HashMap перед использованием. Помните, что тип значения для HashMap теперь Bytes (который мы можем дешево клонировать), поэтому это также нужно изменить.

#![allow(unused)] fn main() { use tokio::net::TcpStream; use mini_redis::{Connection, Frame}; use std::collections::HashMap; use std::sync::{Arc, Mutex}; type Db = Arc<Mutex<HashMap<String, bytes::Bytes>>>; async fn process(socket: TcpStream, db: Db) { use mini_redis::Command::{self, Get, Set}; // Connection, предоставляемый `mini-redis`, обрабатывает разбор фреймов из сокета let mut connection = Connection::new(socket); while let Some(frame) = connection.read_frame().await.unwrap() { let response = match Command::from_frame(frame).unwrap() { Set(cmd) => { let mut db = db.lock().unwrap(); db.insert(cmd.key().to_string(), cmd.value().clone()); Frame::Simple("OK".to_string()) } Get(cmd) => { let db = db.lock().unwrap(); if let Some(value) = db.get(cmd.key()) { Frame::Bulk(value.clone()) } else { Frame::Null } } cmd => panic!("unimplemented {:?}", cmd), }; // Записываем ответ клиенту connection.write_frame(&response).await.unwrap(); } } }

Удержание MutexGuard через .await

Вы можете написать код, который выглядит так:

#![allow(unused)] fn main() { use std::sync::{Mutex, MutexGuard}; async fn increment_and_do_stuff(mutex: &Mutex<i32>) { let mut lock: MutexGuard<i32> = mutex.lock().unwrap(); *lock += 1; do_something_async().await; } // lock выходит из области видимости здесь async fn do_something_async() {} }

Когда вы попытаетесь создать что-то, что вызывает эту функцию, вы столкнетесь со следующей ошибкой:

error: future cannot be sent between threads safely

--> src/lib.rs:13:5

|

13 | tokio::spawn(async move {

| ^^^^^^^^^^^^ future created by async block is not `Send`

|

::: /playground/.cargo/registry/src/github.com-1ecc6299db9ec823/tokio-0.2.21/src/task/spawn.rs:127:21

|

127 | T: Future + Send + 'static,

| ---- required by this bound in `tokio::task::spawn::spawn`

|

= help: within `impl std::future::Future`, the trait `std::marker::Send` is not implemented for `std::sync::MutexGuard<'_, i32>`

note: future is not `Send` as this value is used across an await

--> src/lib.rs:7:5

|

4 | let mut lock: MutexGuard<i32> = mutex.lock().unwrap();

| -------- has type `std::sync::MutexGuard<'_, i32>` which is not `Send`

...

7 | do_something_async().await;

| ^^^^^^^^^^^^^^^^^^^^^^^^^^ await occurs here, with `mut lock` maybe used later

8 | }

| - `mut lock` is later dropped here

Это происходит потому, что тип std::sync::MutexGuard не является Send. Это означает, что вы не можете отправить блокировку мьютекса в другой поток, и ошибка возникает потому, что среда выполнения Tokio может перемещать задачу между потоками при каждом .await. Чтобы избежать этого, вы должны переструктурировать ваш код так, чтобы деструктор блокировки мьютекса выполнялся до .await.

#![allow(unused)] fn main() { use std::sync::{Mutex, MutexGuard}; // Это работает! async fn increment_and_do_stuff(mutex: &Mutex<i32>) { { let mut lock: MutexGuard<i32> = mutex.lock().unwrap(); *lock += 1; } // lock выходит из области видимости здесь do_something_async().await; } async fn do_something_async() {} }

Обратите внимание, что это не работает:

#![allow(unused)] fn main() { use std::sync::{Mutex, MutexGuard}; // Это тоже не работает. async fn increment_and_do_stuff(mutex: &Mutex<i32>) { let mut lock: MutexGuard<i32> = mutex.lock().unwrap(); *lock += 1; drop(lock); do_something_async().await; } async fn do_something_async() {} }

Это потому, что компилятор в настоящее время вычисляет, является ли future Send, на основе только информации об области видимости. Надеюсь, компилятор будет обновлен для поддержки явного удаления в будущем, но сейчас вы должны явно использовать область видимости.

Обратите внимание, что ошибка, обсуждаемая здесь, также обсуждается в разделе Send bound из главы о создании задач.

Вы не должны пытаться обойти эту проблему, создавая задачу способом, который не требует, чтобы она была Send, потому что если Tokio приостановит вашу задачу на .await, пока задача удерживает блокировку, другая задача может быть запланирована на выполнение в том же потоке, и эта другая задача также может попытаться заблокировать этот мьютекс, что приведет к взаимной блокировке, поскольку задача, ожидающая блокировки мьютекса, предотвратит освобождение мьютекса задачей, удерживающей мьютекс.

Имейте в виду, что некоторые крейты мьютексов реализуют Send для своих MutexGuards. В этом случае нет ошибки компилятора, даже если вы удерживаете MutexGuard через .await. Код компилируется, но он взаимно блокируется!

Мы обсудим некоторые подходы к избежанию этих проблем ниже:

Переструктурируйте ваш код, чтобы не удерживать блокировку через .await

Самый безопасный способ обработки мьютекса - это обернуть его в структуру и блокировать мьютекс только внутри не-асинхронных методов этой структуры.

#![allow(unused)] fn main() { use std::sync::Mutex; struct CanIncrement { mutex: Mutex<i32>, } impl CanIncrement { // Эта функция не помечена как async. fn increment(&self) { let mut lock = self.mutex.lock().unwrap(); *lock += 1; } } async fn increment_and_do_stuff(can_incr: &CanIncrement) { can_incr.increment(); do_something_async().await; } async fn do_something_async() {} }

Этот шаблон гарантирует, что вы не столкнетесь с ошибкой Send, потому что защита мьютекса не появляется нигде в асинхронной функции. Это также защищает вас от взаимных блокировок при использовании крейтов, чей MutexGuard реализует Send.

Вы можете найти более подробный пример в этом посте блога.

Создайте задачу для управления состоянием и используйте передачу сообщений для работы с ним

Это второй подход, упомянутый в начале этой главы, и он часто используется, когда общий ресурс является ресурсом I/O. Смотрите следующую главу для более подробной информации.

Используйте асинхронный мьютекс Tokio

Тип tokio::sync::Mutex, предоставляемый Tokio, также может быть использован. Основная особенность мьютекса Tokio заключается в том, что его можно удерживать через .await без каких-либо проблем. Тем не менее, асинхронный мьютекс дороже, чем обычный мьютекс, и обычно лучше использовать один из двух других подходов.

#![allow(unused)] fn main() { use tokio::sync::Mutex; //注意! Это использует мьютекс Tokio // Это компилируется! // (но переструктурирование кода было бы лучше в этом случае) async fn increment_and_do_stuff(mutex: &Mutex<i32>) { let mut lock = mutex.lock().await; *lock += 1; do_something_async().await; } // lock выходит из области видимости здесь async fn do_something_async() {} }

Задачи, потоки и конкуренция

Использование блокирующего мьютекса для защиты коротких критических секций является приемлемой стратегией, когда конкуренция минимальна. Когда блокировка оспаривается, поток, выполняющий задачу, должен блокироваться и ждать мьютекс. Это не только заблокирует текущую задачу, но также заблокирует все другие задачи, запланированные на текущем потоке.

По умолчанию среда выполнения Tokio использует многопоточный планировщик. Задачи планируются на любом количестве потоков, управляемых средой выполнения. Если большое количество задач запланировано на выполнение и все они требуют доступа к мьютексу, то будет конкуренция. С другой стороны, если используется вариант среды выполнения current_thread, то мьютекс никогда не будет оспариваться.

информация Вариант среды выполнения

current_thread- это легковесная однопоточная среда выполнения. Это хороший выбор, когда создается только несколько задач и открывается несколько сокетов. Например, этот вариант хорошо работает при предоставлении синхронного API-моста поверх асинхронной клиентской библиотеки.

Если конкуренция на синхронном мьютексе становится проблемой, лучшим исправлением редко является переключение на мьютекс Tokio. Вместо этого варианты, которые следует рассмотреть, это:

- Позволить выделенной задаче управлять состоянием и использовать передачу сообщений.

- Шардировать мьютекс.

- Переструктурировать код, чтобы избежать мьютекса.

Шардирование мьютекса

В нашем случае, поскольку каждый ключ независим, шардирование мьютекса будет работать хорошо. Для этого вместо одного экземпляра Mutex<HashMap<_, _>> мы введем N различных экземпляров.

#![allow(unused)] fn main() { use std::collections::HashMap; use std::sync::{Arc, Mutex}; type ShardedDb = Arc<Vec<Mutex<HashMap<String, Vec<u8>>>>>; fn new_sharded_db(num_shards: usize) -> ShardedDb { let mut db = Vec::with_capacity(num_shards); for _ in 0..num_shards { db.push(Mutex::new(HashMap::new())); } Arc::new(db) } }

Затем поиск ячейки для любого заданного ключа становится двухэтапным процессом. Сначала ключ используется для идентификации, к какому шарду он принадлежит. Затем ключ ищется в HashMap.

#![allow(unused)] fn main() { let shard = db[hash(key) % db.len()].lock().unwrap(); shard.insert(key, value); }

Простая реализация, описанная выше, требует использования фиксированного числа шардов, и количество шардов не может быть изменено после создания шардированной карты.

Крейт dashmap предоставляет реализацию более сложной шардированной хэш-карты. Вы также можете посмотреть на такие реализации конкурентных хэш-таблиц, как leapfrog и flurry, последняя является портом структуры данных ConcurrentHashMap Java.

Прежде чем вы начнете использовать любой из этих крейтов, убедитесь, что вы структурировали свой код так, чтобы вы не могли удерживать MutexGuard через .await. Если вы этого не сделаете, у вас либо будут ошибки компилятора (в случае не-Send защит), либо ваш код взаимно заблокируется (в случае Send защит). Смотрите полный пример и больше контекста в этом посте блога.

Каналы

Теперь, когда мы немного узнали о параллелизме с Tokio, давайте применим это на стороне клиента. Поместим код сервера, который мы написали ранее, в отдельный бинарный файл:

$ mkdir src/bin

$ mv src/main.rs src/bin/server.rs

и создадим новый бинарный файл, который будет содержать код клиента:

$ touch src/bin/client.rs

В этом файле вы будете писать код этой страницы. Когда вы захотите запустить его, вам нужно будет сначала запустить сервер в отдельном окне терминала:

$ cargo run --bin server

А затем клиент отдельно:

$ cargo run --bin client

Что ж, давайте программировать!

Допустим, мы хотим выполнить две параллельные команды Redis. Мы можем создать по одной задаче для каждой команды. Тогда две команды будут выполняться параллельно.

Сначала мы можем попробовать что-то вроде:

use mini_redis::client; #[tokio::main] async fn main() { // Устанавливаем соединение с сервером let mut client = client::connect("127.0.0.1:6379").await.unwrap(); // Создаем две задачи: одна получает ключ, другая устанавливает ключ let t1 = tokio::spawn(async { let res = client.get("foo").await; }); let t2 = tokio::spawn(async { client.set("foo", "bar".into()).await; }); t1.await.unwrap(); t2.await.unwrap(); }

Это не компилируется, потому что обе задачи должны как-то обращаться к client. Поскольку Client не реализует Copy, код не скомпилируется без некоторого кода для облегчения этого совместного использования. Кроме того, Client::set принимает &mut self, что означает, что требуется эксклюзивный доступ для его вызова. Мы могли бы открыть соединение для каждой задачи, но это не идеально. Мы не можем использовать std::sync::Mutex, так как .await нужно вызывать с удержанной блокировкой. Мы могли бы использовать tokio::sync::Mutex, но это позволило бы выполнять только один запрос одновременно. Если клиент реализует конвейеризацию (кратко: отправка многих команд без ожидания ответа на каждую предыдущую команду), асинхронный мьютекс приводит к неполному использованию соединения.

Передача сообщений

Ответ заключается в использовании передачи сообщений. Шаблон включает создание выделенной задачи для управления ресурсом client. Любая задача, которая хочет выполнить запрос, отправляет сообщение задаче client. Задача client выполняет запрос от имени отправителя, и ответ отправляется обратно отправителю.

Используя эту стратегию, устанавливается единственное соединение. Задача, управляющая client, может получить эксклюзивный доступ для вызова get и set. Кроме того, канал работает как буфер. Операции могут быть отправлены задаче client, пока она занята. Как только задача client становится доступной для обработки новых запросов, она извлекает следующий запрос из канала. Это может привести к лучшей пропускной способности и быть расширено для поддержки пула соединений.

Примитивы каналов Tokio

Tokio предоставляет несколько каналов, каждый из которых служит своей цели.

- mpsc: многопоточный отправитель, однопоточный получатель. Можно отправить много значений.

- oneshot: однопоточный отправитель, однопоточный получатель. Можно отправить одно значение.

- broadcast: многопоточный отправитель, многопоточный получатель. Можно отправить много значений. Каждый получатель видит каждое значение.

- watch: многопоточный отправитель, многопоточный получатель. Можно отправить много значений, но история не сохраняется. Получатели видят только последнее значение.

Если вам нужен многопоточный отправитель/многопоточный получатель канала, где только один получатель видит каждое сообщение, вы можете использовать крейт async-channel. Также существуют каналы для использования вне асинхронного Rust, такие как std::sync::mpsc и crossbeam::channel. Эти каналы ожидают сообщения, блокируя поток, что не допускается в асинхронном коде.

В этом разделе мы будем использовать mpsc и oneshot. Другие типы каналов передачи сообщений исследуются в последующих разделах. Полный код из этого раздела находится здесь.

Определение типа сообщения

В большинстве случаев, при использовании передачи сообщений, задача, получающая сообщения, отвечает более чем на одну команду. В нашем случае задача будет отвечать на команды GET и SET. Чтобы смоделировать это, мы сначала определим перечисление Command и включим вариант для каждого типа команды.

#![allow(unused)] fn main() { use bytes::Bytes; #[derive(Debug)] enum Command { Get { key: String, }, Set { key: String, val: Bytes, } } }

Создание канала

В функции main создается канал mpsc.

use tokio::sync::mpsc; #[tokio::main] async fn main() { // Создаем новый канал с емкостью не более 32. let (tx, mut rx) = mpsc::channel(32); tx.send(()).await.unwrap(); // ... Дальнейший код здесь }

Канал mpsc используется для отправки команд задаче, управляющей соединением redis. Возможность многопоточности позволяет отправлять сообщения из многих задач. Создание канала возвращает два значения: отправитель и получатель. Два handle используются отдельно. Они могут быть перемещены в разные задачи.

Канал создается с емкостью 32. Если сообщения отправляются быстрее, чем принимаются, канал будет их хранить. После того как в канале сохранено 32 сообщения, вызов send(...).await перейдет в режим ожидания, пока сообщение не будет удалено получателем.

Отправка из нескольких задач осуществляется путем клонирования Sender. Например:

use tokio::sync::mpsc; #[tokio::main] async fn main() { let (tx, mut rx) = mpsc::channel(32); let tx2 = tx.clone(); tokio::spawn(async move { tx.send("sending from first handle").await.unwrap(); }); tokio::spawn(async move { tx2.send("sending from second handle").await.unwrap(); }); while let Some(message) = rx.recv().await { println!("GOT = {}", message); } }

Оба сообщения отправляются в единственный handle Receiver. Невозможно клонировать получателя канала mpsc.

Когда каждый Sender вышел из области видимости или иным образом был удален, больше невозможно отправлять сообщения в канал. В этот момент вызов recv на Receiver вернет None, что означает, что все отправители исчезли и канал закрыт.

В нашем случае задачи, управляющей соединением Redis, она знает, что может закрыть соединение Redis, когда канал закрыт, так как соединение больше не будет использоваться.

Создание задачи-менеджера

Далее создадим задачу, которая обрабатывает сообщения из канала. Сначала устанавливается клиентское соединение с Redis. Затем полученные команды выполняются через соединение Redis.

#![allow(unused)] fn main() { use mini_redis::client; enum Command { Get { key: String }, Set { key: String, val: bytes::Bytes } } async fn dox() { let (_, mut rx) = tokio::sync::mpsc::channel(10); // Ключевое слово `move` используется для **перемещения** владения `rx` в задачу. let manager = tokio::spawn(async move { // Устанавливаем соединение с сервером let mut client = client::connect("127.0.0.1:6379").await.unwrap(); // Начинаем получать сообщения while let Some(cmd) = rx.recv().await { use Command::*; match cmd { Get { key } => { client.get(&key).await; } Set { key, val } => { client.set(&key, val).await; } } } }); } }

Теперь обновим две задачи для отправки команд через канал вместо их непосредственного выполнения на соединении Redis.

#![allow(unused)] fn main() { #[derive(Debug)] enum Command { Get { key: String }, Set { key: String, val: bytes::Bytes } } async fn dox() { let (mut tx, _) = tokio::sync::mpsc::channel(10); // Handle `Sender` перемещаются в задачи. Поскольку есть две задачи, нам нужен второй `Sender`. let tx2 = tx.clone(); // Создаем две задачи: одна получает ключ, другая устанавливает ключ let t1 = tokio::spawn(async move { let cmd = Command::Get { key: "foo".to_string(), }; tx.send(cmd).await.unwrap(); }); let t2 = tokio::spawn(async move { let cmd = Command::Set { key: "foo".to_string(), val: "bar".into(), }; tx2.send(cmd).await.unwrap(); }); } }

Внизу функции main мы используем .await для join handles, чтобы гарантировать полное завершение команд перед выходом из процесса.

#![allow(unused)] fn main() { type Jh = tokio::task::JoinHandle<()>; async fn dox(t1: Jh, t2: Jh, manager: Jh) { t1.await.unwrap(); t2.await.unwrap(); manager.await.unwrap(); } }

Получение ответов

Последний шаг — получение ответа от задачи-менеджера. Команде GET нужно получить значение, а команде SET нужно знать, успешно ли завершилась операция.

Для передачи ответа используется канал oneshot. Канал oneshot — это канал с одним отправителем и одним получателем, оптимизированный для отправки одного значения. В нашем случае единственное значение — это ответ.

Аналогично mpsc, oneshot::channel() возвращает handle отправителя и получателя.

#![allow(unused)] fn main() { use tokio::sync::oneshot; async fn dox() { let (tx, rx) = oneshot::channel(); tx.send(()).unwrap(); } }

В отличие от mpsc, емкость не указывается, так как она всегда равна единице. Кроме того, ни один из handle не может быть клонирован.

Для получения ответов от задачи-менеджера, перед отправкой команды создается канал oneshot. Половина Sender канала включается в команду для задачи-менеджера. Половина получения используется для получения ответа.

Сначала обновим Command, чтобы включить Sender. Для удобства используется псевдоним типа для ссылки на Sender.

#![allow(unused)] fn main() { use tokio::sync::oneshot; use bytes::Bytes; /// Несколько различных команд мультиплексируются через один канал. #[derive(Debug)] enum Command { Get { key: String, resp: Responder<Option<Bytes>>, }, Set { key: String, val: Bytes, resp: Responder<()>, }, } /// Предоставляется запрашивающей стороной и используется задачей-менеджером для отправки ответа на команду обратно запрашивающей стороне. type Responder<T> = oneshot::Sender<mini_redis::Result<T>>; }

Теперь обновим задачи, выполняющие команды, чтобы включить oneshot::Sender.

#![allow(unused)] fn main() { use tokio::sync::{oneshot, mpsc}; use bytes::Bytes; #[derive(Debug)] enum Command { Get { key: String, resp: Responder<Option<bytes::Bytes>> }, Set { key: String, val: Bytes, resp: Responder<()> }, } type Responder<T> = oneshot::Sender<mini_redis::Result<T>>; fn dox() { let (mut tx, mut rx) = mpsc::channel(10); let mut tx2 = tx.clone(); let t1 = tokio::spawn(async move { let (resp_tx, resp_rx) = oneshot::channel(); let cmd = Command::Get { key: "foo".to_string(), resp: resp_tx, }; // Отправляем запрос GET tx.send(cmd).await.unwrap(); // Ожидаем ответ let res = resp_rx.await; println!("GOT = {:?}", res); }); let t2 = tokio::spawn(async move { let (resp_tx, resp_rx) = oneshot::channel(); let cmd = Command::Set { key: "foo".to_string(), val: "bar".into(), resp: resp_tx, }; // Отправляем запрос SET tx2.send(cmd).await.unwrap(); // Ожидаем ответ let res = resp_rx.await; println!("GOT = {:?}", res); }); } }

Наконец, обновим задачу-менеджер для отправки ответа через канал oneshot.

#![allow(unused)] fn main() { use tokio::sync::{oneshot, mpsc}; use bytes::Bytes; #[derive(Debug)] enum Command { Get { key: String, resp: Responder<Option<bytes::Bytes>> }, Set { key: String, val: Bytes, resp: Responder<()> }, } type Responder<T> = oneshot::Sender<mini_redis::Result<T>>; async fn dox(mut client: mini_redis::client::Client) { let (_, mut rx) = mpsc::channel::<Command>(10); while let Some(cmd) = rx.recv().await { match cmd { Command::Get { key, resp } => { let res = client.get(&key).await; // Игнорируем ошибки let _ = resp.send(res); } Command::Set { key, val, resp } => { let res = client.set(&key, val).await; // Игнорируем ошибки let _ = resp.send(res); } } } } }

Вызов send на oneshot::Sender завершается немедленно и не требует .await. Это связано с тем, что send на канале oneshot всегда завершается неудачей или успехом немедленно без какого-либо ожидания.

Отправка значения на канал oneshot возвращает Err, когда половина получателя была удалена. Это указывает, что получатель больше не заинтересован в ответе. В нашем сценарии отмена интереса получателем является допустимым событием. Ошибка Err, возвращаемая resp.send(...), не требует обработки.

Вы можете найти полный код здесь.

Обратное давление и ограниченные каналы

Всякий раз, когда вводится параллелизм или очереди, важно обеспечить, чтобы очереди были ограничены и система могла корректно обрабатывать нагрузку. Неограниченные очереди в конечном итоге заполнят всю доступную память и вызовут сбой системы непредсказуемым образом.

Tokio заботится о том, чтобы избежать неявного создания очередей. Большая часть этого заключается в том, что асинхронные операции ленивы. Рассмотрим следующее:

fn async_op() {} fn dox() { loop { async_op(); } } fn main() {}

Если асинхронная операция выполняется активно, цикл будет повторно ставить в очередь новую async_op для выполнения без обеспечения завершения предыдущей операции. Это приводит к неявному неограниченному созданию очередей. Системы на основе обратных вызовов и системы на основе активных future особенно подвержены этому.

Однако с Tokio и асинхронным Rust приведенный фрагмент не приведет к выполнению async_op вообще. Это потому, что .await никогда не вызывается. Если фрагмент обновлен для использования .await, то цикл ждет завершения операции перед началом нового цикла.

async fn async_op() {} async fn dox() { loop { // Не повторится, пока `async_op` не завершится async_op().await; } } fn main() {}

Параллелизм и очереди должны вводиться явно. Способы сделать это включают:

tokio::spawnselect!join!mpsc::channel

При этом позаботьтесь о том, чтобы общий объем параллелизма был ограничен. Например, при написании цикла принятия TCP убедитесь, что общее количество открытых сокетов ограничено. При использовании mpsc::channel выберите управляемую емкость канала. Конкретные значения границ будут зависеть от приложения.

Забота и выбор хороших границ — большая часть написания надежных приложений Tokio.

I/O

Ввод-вывод в Tokio работает во многом так же, как и в std, но асинхронно. Существует трейт для чтения (AsyncRead) и трейт для записи (AsyncWrite). Конкретные типы реализуют эти трейты соответствующим образом (TcpStream, File, Stdout). AsyncRead и AsyncWrite также реализованы для ряда структур данных, таких как Vec<u8> и &[u8]. Это позволяет использовать байтовые массивы там, где ожидается читатель или писатель.

На этой странице будут рассмотрены базовое чтение и запись ввода-вывода с Tokio и пройдены несколько примеров. На следующей странице мы перейдем к более продвинутому примеру ввода-вывода.

AsyncRead и AsyncWrite

Эти два трейта предоставляют возможности для асинхронного чтения из байтовых потоков и записи в них. Методы этих трейтов обычно не вызываются напрямую, аналогично тому, как вы не вызываете вручную метод poll из трейта Future. Вместо этого вы будете использовать их через вспомогательные методы, предоставляемые AsyncReadExt и AsyncWriteExt.

Давайте кратко рассмотрим несколько из этих методов. Все эти функции являются async и должны использоваться с .await.

async fn read()

AsyncReadExt::read предоставляет асинхронный метод для чтения данных в буфер, возвращая количество прочитанных байтов.

Примечание: когда read() возвращает Ok(0), это означает, что поток закрыт. Любые последующие вызовы read() будут немедленно завершаться с Ok(0). Для экземпляров TcpStream это означает, что половина сокета для чтения закрыта.

use tokio::fs::File; use tokio::io::{self, AsyncReadExt}; fn dox() { #[tokio::main] async fn main() -> io::Result<()> { let mut f = File::open("foo.txt").await?; let mut buffer = [0; 10]; // читаем до 10 байт let n = f.read(&mut buffer[..]).await?; println!("The bytes: {:?}", &buffer[..n]); Ok(()) } }

async fn read_to_end()

AsyncReadExt::read_to_end читает все байты из потока до EOF.

use tokio::io::{self, AsyncReadExt}; use tokio::fs::File; fn dox() { #[tokio::main] async fn main() -> io::Result<()> { let mut f = File::open("foo.txt").await?; let mut buffer = Vec::new(); // читаем весь файл f.read_to_end(&mut buffer).await?; Ok(()) } }

async fn write()

AsyncWriteExt::write записывает буфер в писатель, возвращая количество записанных байтов.

use tokio::io::{self, AsyncWriteExt}; use tokio::fs::File; fn dox() { #[tokio::main] async fn main() -> io::Result<()> { let mut file = File::create("foo.txt").await?; // Записывает некоторый префикс байтовой строки, но не обязательно всю. let n = file.write(b"some bytes").await?; println!("Wrote the first {} bytes of 'some bytes'.", n); Ok(()) } }

async fn write_all()

AsyncWriteExt::write_all записывает весь буфер в писатель.

use tokio::io::{self, AsyncWriteExt}; use tokio::fs::File; fn dox() { #[tokio::main] async fn main() -> io::Result<()> { let mut file = File::create("foo.txt").await?; file.write_all(b"some bytes").await?; Ok(()) } }

Оба трейта включают множество других полезных методов. См. документацию API для полного списка.

Вспомогательные функции

Кроме того, как и в std, модуль tokio::io содержит множество полезных утилитных функций, а также API для работы со стандартным вводом, стандартным выводом и стандартной ошибкой. Например, tokio::io::copy асинхронно копирует все содержимое читателя в писатель.

use tokio::fs::File; use tokio::io; fn dox() { #[tokio::main] async fn main() -> io::Result<()> { let mut reader: &[u8] = b"hello"; let mut file = File::create("foo.txt").await?; io::copy(&mut reader, &mut file).await?; Ok(()) } }

Обратите внимание, что здесь используется тот факт, что байтовые массивы также реализуют AsyncRead.

Эхо-сервер

Давайте попрактикуемся в асинхронном вводе-выводе. Мы напишем эхо-сервер.

Эхо-сервер привязывает TcpListener и принимает входящие соединения в цикле. Для каждого входящего соединения данные читаются из сокета и немедленно записываются обратно в сокет. Клиент отправляет данные на сервер и получает точно такие же данные обратно.

Мы реализуем эхо-сервер дважды, используя немного разные стратегии.

Использование io::copy()

Для начала мы реализуем логику эха с помощью утилиты io::copy.

Вы можете написать этот код в новом бинарном файле:

$ touch src/bin/echo-server-copy.rs

Который вы можете запустить (или просто проверить компиляцию) с помощью:

$ cargo run --bin echo-server-copy

Вы сможете испытать сервер, используя стандартное командное средство, такое как telnet, или написав простой клиент, подобный тому, который находится в документации для tokio::net::TcpStream.

Это TCP-сервер, и ему нужен цикл принятия. Для каждого принятого сокета создается новая задача.

use tokio::io; use tokio::net::TcpListener; fn dox() { #[tokio::main] async fn main() -> io::Result<()> { let listener = TcpListener::bind("127.0.0.1:6142").await?; loop { let (mut socket, _) = listener.accept().await?; tokio::spawn(async move { // Копируем данные здесь }); } } }

Как было показано ранее, эта утилитная функция принимает читателя и писателя и копирует данные из одного в другой. Однако у нас есть только один TcpStream. Этот единственный значение реализует и AsyncRead, и AsyncWrite. Поскольку io::copy требует &mut как для читателя, так и для писателя, сокет не может быть использован для обоих аргументов.

#![allow(unused)] fn main() { // Это не компилируется io::copy(&mut socket, &mut socket).await }

Разделение читателя + писателя

Чтобы обойти эту проблему, мы должны разделить сокет на handle читателя и handle писателя. Лучший способ разделить комбинацию читатель/писатель зависит от конкретного типа.

Любой тип читатель + писатель может быть разделен с помощью утилиты io::split. Эта функция принимает одно значение и возвращает отдельные handle читателя и писателя. Эти два handle могут использоваться независимо, в том числе из отдельных задач.

Например, эхо-клиент может обрабатывать конкурентные чтение и запись следующим образом:

use tokio::io::{self, AsyncReadExt, AsyncWriteExt}; use tokio::net::TcpStream; fn dox() { #[tokio::main] async fn main() -> io::Result<()> { let socket = TcpStream::connect("127.0.0.1:6142").await?; let (mut rd, mut wr) = io::split(socket); // Записываем данные в фоне tokio::spawn(async move { wr.write_all(b"hello\r\n").await?; wr.write_all(b"world\r\n").await?; // Иногда rust выводу типов нужна небольшая помощь Ok::<_, io::Error>(()) }); let mut buf = vec![0; 128]; loop { let n = rd.read(&mut buf).await?; if n == 0 { break; } println!("GOT {:?}", &buf[..n]); } Ok(()) } }

Поскольку io::split поддерживает любое значение, которое реализует AsyncRead + AsyncWrite, и возвращает независимые handle, внутри io::split используется Arc и Mutex. Этих накладных расходов можно избежать с TcpStream. TcpStream предлагает две специализированные функции разделения.

TcpStream::split принимает ссылку на поток и возвращает handle читателя и писателя. Поскольку используется ссылка, оба handle должны оставаться в той же задаче, из которой был вызван split(). Это специализированное split является бесплатным. Не нужны Arc или Mutex. TcpStream также предоставляет into_split, который поддерживает handle, которые могут перемещаться между задачами, ценой только Arc.

Поскольку io::copy() вызывается в той же задаче, которой принадлежит TcpStream, мы можем использовать TcpStream::split. Задача, которая обрабатывает логику эха в сервере, становится:

#![allow(unused)] fn main() { use tokio::io; use tokio::net::TcpStream; fn dox(mut socket: TcpStream) { tokio::spawn(async move { let (mut rd, mut wr) = socket.split(); if io::copy(&mut rd, &mut wr).await.is_err() { eprintln!("failed to copy"); } }); } }

Полный код можно найти здесь.

Ручное копирование

Теперь давайте посмотрим, как мы бы написали эхо-сервер, копируя данные вручную. Для этого мы используем AsyncReadExt::read и AsyncWriteExt::write_all.

Полный эхо-сервер выглядит следующим образом:

use tokio::io::{self, AsyncReadExt, AsyncWriteExt}; use tokio::net::TcpListener; fn dox() { #[tokio::main] async fn main() -> io::Result<()> { let listener = TcpListener::bind("127.0.0.1:6142").await?; loop { let (mut socket, _) = listener.accept().await?; tokio::spawn(async move { let mut buf = vec![0; 1024]; loop { match socket.read(&mut buf).await { // Возвращаемое значение `Ok(0)` означает, что удаленная сторона закрыта Ok(0) => return, Ok(n) => { // Копируем данные обратно в сокет if socket.write_all(&buf[..n]).await.is_err() { // Неожиданная ошибка сокета. Здесь мало что можно сделать, поэтому просто останавливаем обработку. return; } } Err(_) => { // Неожиданная ошибка сокета. Здесь мало что можно сделать, поэтому просто останавливаем обработку. return; } } } }); } } }

(Вы можете поместить этот код в src/bin/echo-server.rs и запустить его с помощью cargo run --bin echo-server).

Давайте разберем его. Во-первых, поскольку используются утилиты AsyncRead и AsyncWrite, трейты расширения должны быть внесены в область видимости.

#![allow(unused)] fn main() { use tokio::io::{self, AsyncReadExt, AsyncWriteExt}; }

Выделение буфера

Стратегия заключается в том, чтобы прочитать некоторые данные из сокета в буфер, а затем записать содержимое буфера обратно в сокет.

#![allow(unused)] fn main() { let mut buf = vec![0; 1024]; }

Явно избегается стековый буфер. Вспомним из ранее, мы отметили, что все данные задачи, которые живут между вызовами .await, должны храниться задачей. В этом случае buf используется между вызовами .await. Все данные задачи хранятся в одном выделении памяти. Вы можете думать об этом как о enum, где каждый вариант - это данные, которые нужно хранить для конкретного вызова .await.

Если буфер представлен стековым массивом, внутренняя структура для задач, созданных для каждого принятого сокета, может выглядеть примерно так:

#![allow(unused)] fn main() { struct Task { // внутренние поля задачи здесь task: enum { AwaitingRead { socket: TcpStream, buf: [BufferType], }, AwaitingWriteAll { socket: TcpStream, buf: [BufferType], } } } }

Если стековый массив используется как тип буфера, он будет храниться встроенным в структуру задачи. Это сделает структуру задачи очень большой. Кроме того, размеры буферов часто равны размеру страницы. Это, в свою очередь, сделает Task неудобного размера: $page-size + несколько-байт.

Компилятор оптимизирует расположение async блоков дальше, чем базовый enum. На практике переменные не перемещаются между вариантами, как это было бы необходимо с enum. Однако размер структуры задачи по крайней мере такой же большой, как самая большая переменная.

Из-за этого обычно более эффективно использовать выделенное выделение памяти для буфера.

Обработка EOF

Когда половина TCP-потока для чтения закрыта, вызов read() возвращает Ok(0). Важно выйти из цикла чтения в этот момент. Забывание прервать цикл чтения при EOF является распространенным источником ошибок.

#![allow(unused)] fn main() { use tokio::io::AsyncReadExt; use tokio::net::TcpStream; async fn dox(mut socket: TcpStream) { let mut buf = vec![0_u8; 1024]; loop { match socket.read(&mut buf).await { // Возвращаемое значение `Ok(0)` означает, что удаленная сторона закрыта Ok(0) => return, // ... другие случаи обрабатываются здесь _ => unreachable!(), } } } }

Забывание прервать цикл чтения обычно приводит к ситуации бесконечного цикла с 100% загрузкой CPU. Поскольку сокет закрыт, socket.read() возвращается немедленно. Цикл затем повторяется вечно.

Полный код можно найти здесь.

Framing

Теперь мы применим то, что только что узнали о вводе-выводе, и реализуем слой фрейминга для Mini-Redis. Фрейминг - это процесс преобразования байтового потока в поток фреймов. Фрейм - это единица данных, передаваемая между двумя узлами. Протокольный фрейм Redis определяется следующим образом:

#![allow(unused)] fn main() { use bytes::Bytes; enum Frame { Simple(String), Error(String), Integer(u64), Bulk(Bytes), Null, Array(Vec<Frame>), } }

Обратите внимание, что фрейм состоит только из данных без какой-либо семантики. Разбор команд и их реализация происходят на более высоком уровне.

Для HTTP фрейм может выглядеть так:

#![allow(unused)] fn main() { use bytes::Bytes; type Method = (); type Uri = (); type Version = (); type HeaderMap = (); type StatusCode = (); enum HttpFrame { RequestHead { method: Method, uri: Uri, version: Version, headers: HeaderMap, }, ResponseHead { status: StatusCode, version: Version, headers: HeaderMap, }, BodyChunk { chunk: Bytes, }, } }

Чтобы реализовать фрейминг для Mini-Redis, мы реализуем структуру Connection, которая оборачивает TcpStream и читает/пишет значения mini_redis::Frame.

#![allow(unused)] fn main() { use tokio::net::TcpStream; use mini_redis::{Frame, Result}; struct Connection { stream: TcpStream, // ... другие поля здесь } impl Connection { /// Читает фрейм из соединения. /// /// Возвращает `None`, если достигнут EOF pub async fn read_frame(&mut self) -> Result<Option<Frame>> { // реализация здесь unimplemented!(); } /// Записывает фрейм в соединение. pub async fn write_frame(&mut self, frame: &Frame) -> Result<()> { // реализация здесь unimplemented!(); } } }

Подробности протокола Redis можно найти здесь. Полный код Connection находится здесь.

Буферизованное чтение

Метод read_frame ожидает получения всего фрейма перед возвратом. Один вызов TcpStream::read() может вернуть произвольное количество данных. Это может содержать целый фрейм, частичный фрейм или несколько фреймов. Если получен частичный фрейм, данные буферизуются и считываются дополнительные данные из сокета. Если получено несколько фреймов, возвращается первый фрейм, а остальные данные буферизуются до следующего вызова read_frame.

Если вы еще этого не сделали, создайте новый файл с именем connection.rs.

touch src/connection.rs

Для реализации этого Connection нуждается в поле буфера чтения. Данные считываются из сокета в буфер чтения. Когда фрейм разбирается, соответствующие данные удаляются из буфера.

Мы будем использовать BytesMut в качестве типа буфера. Это изменяемая версия Bytes.

#![allow(unused)] fn main() { use bytes::BytesMut; use tokio::net::TcpStream; pub struct Connection { stream: TcpStream, buffer: BytesMut, } impl Connection { pub fn new(stream: TcpStream) -> Connection { Connection { stream, // Выделяем буфер вместимостью 4 КБ. buffer: BytesMut::with_capacity(4096), } } } }

Далее мы реализуем метод read_frame().

#![allow(unused)] fn main() { use tokio::io::AsyncReadExt; use bytes::Buf; use mini_redis::Result; struct Connection { stream: tokio::net::TcpStream, buffer: bytes::BytesMut, } struct Frame {} impl Connection { pub async fn read_frame(&mut self) -> Result<Option<Frame>> { loop { // Попытка разобрать фрейм из буферизованных данных. Если // было буферизовано достаточно данных, фрейм возвращается. if let Some(frame) = self.parse_frame()? { return Ok(Some(frame)); } // Недостаточно буферизованных данных для чтения фрейма. // Попытка прочитать больше данных из сокета. // // При успехе возвращается количество байтов. `0` // указывает на "конец потока". if 0 == self.stream.read_buf(&mut self.buffer).await? { // Удаленная сторона закрыла соединение. Для чистого // завершения в буфере чтения не должно быть данных. // Если они есть, это означает, что узел закрыл сокет // во время отправки фрейма. if self.buffer.is_empty() { return Ok(None); } else { return Err("connection reset by peer".into()); } } } } fn parse_frame(&self) -> Result<Option<Frame>> { unimplemented!() } } }

Давайте разберем это. Метод read_frame работает в цикле. Сначала вызывается self.parse_frame(). Это попытается разобрать фрейм redis из self.buffer. Если есть достаточно данных для разбора фрейма, фрейм возвращается вызывающей стороне read_frame(). В противном случае мы пытаемся прочитать больше данных из сокета в буфер. После чтения дополнительных данных parse_frame() вызывается снова. На этот раз, если было получено достаточно данных, разбор может быть успешным.

При чтении из потока возвращаемое значение 0 указывает, что больше данных от узла получено не будет. Если в буфере чтения все еще есть данные, это указывает на то, что был получен частичный фрейм и соединение завершается внезапно. Это ошибочная ситуация, и возвращается Err.

Трейт Buf